카테고리 없음

[Istio-7주차] Istio 스케일링, 데이터 플레인 확장 (이론, 실습)

- -

12장 조직 내에서 Istio 스케일링하기

배경 설명

- 여러 클러스터에서 서비스 메시 스케일링하기 Scaling the service mesh in multiple clusters

- 두 클러스터를 합치기 위한 전체 조건 해결하기 Resolving the prerequisites to join two clusters

- 여러 클러스터의 워크로드 간에 공통 신뢰 common trust 설정하기 Setting up common trust between workloads of different clusters

- 클러스터 간 워크로드 찾기 Discovering cross-cluster workloads

- east-west 트래픽을 위한 이스티오 인그레스 게이트웨이 설정하기 Configuring Istio’s ingress gateway for east-west traffic

들어가며: 다중 클러스터 서비스 메시

- 이전 장: 단일 클러스터 메시 내 활성화한 Istio 기능 확인.

하지만 서비스 메시는 단일 클러스터에 종속되지 않음- 서비스 메시는 여러 클러스터에 걸쳐 있을 수 있으며, 클러스터 모두에 동일한 기능을 제공할 수 있음

- 사실 메시의 가치는 워크로드가 많아질수록 증가

- 단일 클러스터와 비교할 때 다중 클러스터 서비스 메시는 어떤 이점이 있는 지 확인 (가상의 ACME사)

12.1 다중 클러스터 서비스 메시의 이점

- 소개 : The benefits of a multi-cluster service mesh - Docs

- 클라우드 마이그레이션 초기에 ACME는 클러스터의 규모를 어떻게 조정할지에 대한 딜레마에 직면

- 이 회사는 단일 클러스터로 시작, 신속하게 변경을 결정함.

- ACME는 작은 클러스터 다수을 쓰기로 결정 (사용 시 이점)

- 격리성 강화 Improved isolation

- 한 팀의 사고가 다른 팀에 영향을 끼치지 않음

- 장애 경계 Failure boundary

- 클러스터 전체에 영향을 미칠 수 있는 설정이나 운영에 경계선을 설정

: 클러스터가 다운될 때 아키텍처의 다른 부분에 미치는 영향 최소화

- 클러스터 전체에 영향을 미칠 수 있는 설정이나 운영에 경계선을 설정

- 규정 준수 Regulatory and compliance

- 아키텍처의 다른 부분에서 민감 데이터로 접근하는 서비스를 제한

- 가용성 및 성능 향상 Increased availability and performance

- 가용성을 늘리기 위해 여러 리전에서 클러스터를 운영하고, 가장 가까운 클러스터로 트래픽을 라우팅

: 지연 시간 감소

- 가용성을 늘리기 위해 여러 리전에서 클러스터를 운영하고, 가장 가까운 클러스터로 트래픽을 라우팅

- 다중 및 하이브리드 클라우드 Multi and hybrid clouds

- 서로 다른 클라우드 프로바이더, 하이브리드 클라우드 사용 가능

: 다양한 환경에서 워크로드 실행

- 서로 다른 클라우드 프로바이더, 하이브리드 클라우드 사용 가능

- 격리성 강화 Improved isolation

- ACME가 서비스 메시를 채택 시 초창기 주요 동기가 된 기능들

- 여러 클러스터 간에 서비스 메시를 확장

- 클러스터 간에 트래픽 관리, 관찰 가능성

- 보안 지원

- ACME는 다중 클러스터 작업을 지원하고자 두 가지 접근법 고려 - Docs

- 다중 클러스터 서비스 메시 Multi-cluster service mesh

https://istio.io/latest/docs/ops/deployment/deployment-models/#multiple-clusters

- 여러 클러스터에 걸쳐 있고, 워크로드가 클러스터 간에 트래픽을 라우팅하도록 설정하는 메시

- VirtualService, DestinationRule, Sidecar 등이 적용된 Istio 구성을 전부 따름

- 메시 연합 (다중 메시) Mesh federation, also known as multi-mesh

https://istio.io/latest/docs/ops/deployment/deployment-models/#multiple-meshes

- 개별 서비스 메시 2개 워크로드 간 통신 노출 및 활성화

- 서비스 간 트래픽 설정 시 두 메시 모두에 수동 설정이 필요 (자동화가 덜 됨)

- 서로 다른 팀에서 두 메시를 운영하거나, 보안 격리 요구 사항이 엄격한 경우 좋은 선택지가 됨

- 하기에 다룰 케이스는 다중 클러스터 서비스 메시

(메시 연합 같은 경우에는 공식 문서 참고) - Docs

- 다중 클러스터 서비스 메시 Multi-cluster service mesh

12.2 다중 클러스터 서비스 메시 개요 multi-cluster service mesh

- 소개 : 필요 사항

- 다중 클러스터 서비스 메시에서 서비스 연결 방식

- 앱에는 완전히 투명한 방식으로 클러스터 간에 서비스를 연결

- 그와 동시에 클러스터 간 통신을 위한 서비스 메시의 기능(세밀한 트래픽 제오, 복원력, 관찰 가능성, 보안 등)은 모두 유지

- Istio가 다중 클러스터 서비스 메시를 구현하는 방법

- 모든 클러스터의 서비스를 쿼리 → 쿼리 정보로 서비스 프록시에 트래픽 라우팅 방식 설정 (클러스터 간에서, 서비스 간)

- 클러스터들을 하나의 메시로 결합하는 데 필요한 것 (전제 조건)

멀티 클러스터 서비스 메시는 클러스터 간 워크로드 탐색, 연결성, 공통된 신뢰 필요

- 클러스터 간 워크로드 디스커버리 Cross-cluster workload discovery

- Istio 컨트롤 플레인은 서비스 프록시를 설정하기 위해 동료 k8s 클러스터의 워크로드를 탐색 가능해야 함

(k8s 클러스터 API 서버를 상대편 클러스터의 Istio 컨트롤 플레인에서 접근할 수 있어야 함)

- Istio 컨트롤 플레인은 서비스 프록시를 설정하기 위해 동료 k8s 클러스터의 워크로드를 탐색 가능해야 함

- 클러스터 간 워크로드 연결성 Cross-cluster workload connectivity

- 워크로드는 서로 연결돼 있어야 함

(워크로드 엔드포인트를 인지하고 있어도 커넥션을 시작할 수 없다면 쓸모가 없음)

- 워크로드는 서로 연결돼 있어야 함

- 클러스터 간 공통 신뢰 Common trust between clusters

- 클러스터 간 워크로드가 서로 인증해야 함

(인증해야 Istio의 보안 기능을 활성화할 수 있음)

- 클러스터 간 워크로드가 서로 인증해야 함

- 다중 클러스터 연결성과 보안 Multi-cluster connectivity and security

- Istio가 클러스터 간에 다중 클러스터 연결을 수립하려면, 워크로드는 동료 클러스터의 쿠버네티스 API에 접근하는 방법으로만 찾을 수 있고,

어떤 조직에서는 이것이 바람직하지 않는 보안 태세일 수 있음- 각 클러스터가 다른 클러스터의 API 모두에 접근할 수 있기 때문

- 이 경우에는 메시 연합이 더 나은 방식

- Istio가 클러스터 간에 다중 클러스터 연결을 수립하려면, 워크로드는 동료 클러스터의 쿠버네티스 API에 접근하는 방법으로만 찾을 수 있고,

- 클러스터 간 워크로드 디스커버리 Cross-cluster workload discovery

- 다중 클러스터 서비스 메시에서 서비스 연결 방식

- Istio 다중 클러스터 배포 모델 Istio multi-cluster deployment models - Blog

- 다중 클러스터 서비스 메시에서의 Istio 클러스터 유형 (2가지)

- 기본 클러스터 primary cluster : Istio 컨트롤 플레인이 설치된 K8S 클러스터 → 12.2 그림 중 왼쪽

- 원격 클러스터 remote cluster : 설치된 Istio 컨트롤 플레인과 떨어져 있는 K8S 클러스터 → 12.2 그림 중 오른쪽

기본-원격 배포 모델

- 달성하고자 하는 가용성 수준에 따라 배포 모델 3가지

- 기본-원격(컨트롤 플레인 공유) 배포 모델 primary-remote (shared control plane) → 위 그림 12.2

- 기본-기본(복제된 컨트롤 플레인) 배포 모델 primary-primary (replicated control plane) → 아래 그림 12.3

- 외부 컨트롤 플레인 배포 모델 external control plane → 아래 그림 12.4

- 기본-기본(복제된 컨트롤 플레인) 배포 모델 primary-primary (replicated control plane)

- 복제된 컨트롤 플레인 배포 모델이라고도 부름

- 컨트롤 플레인이 여럿이므로 가용성이 높음

- 중단 범위가 중단이 발생한 클러스터로 국한되기 때문

- 트레이드오프로 인해 리소스가 더 많이 필요

기본-기본 배포 모델

- 외부 컨트롤 플레인 배포 모델 external control plane

- 모든 클러스터가 컨트롤 플레인과 떨어져 있는 배포 모델

- 이 배포 모델을 통해 클라우드 프로바이더가 Istio를 관리형 서비스로 제공 가능

외부 컨트롤 플레인 배포 모델

- 다중 클러스터 서비스 메시에서의 Istio 클러스터 유형 (2가지)

- 다중 클러스터 배포에서 워크로드는 어떻게 찾는가? How workloads are discovered in multi-cluster deployments

- Istio의 컨트롤 플레인은 쿠버네티스 API 서버와 통신해 서비스 프록시 설정 관련 정보 수집 필요

(서비스 뒤의 서비스, 엔드포인트 등) - 쿠버네티스 API 서버에 요청하는 것은 막강한 일종의 권한임

- 리소스 세부 정보를 조회

- 민감 정보를 쿼리 가능

- 클러스터를 불량하고 되돌이킬 수 없는 상태로 만들 수 있는 정도로 리소스를 업데이트하거나 지울 수 있음

- 토큰과 RBAC으로 원격 쿠버네티스 API로의 접근을 보안 처리할 수 있음

다만 이 접근법은 트레이드오프를 고려해야 함

(메시 연합 사용 시 위험성 완화 가능. 앞 장에서 실습한 내용 등을 활용)

- 토큰과 RBAC으로 원격 쿠버네티스 API로의 접근을 보안 처리할 수 있음

- 쿠버네티스는 RBAC를 이용해 API 서버로의 접근을 보호 가능

** 쿠버네티스 RBAC은 광범위한 주제로, Istio 공부 내 범위는 아님 - 쿠버네티스 RBAC에서 클러스터 간 디스커버리를 용이하게 하는 데 사용하는 일부 개념 살펴보기

- Service Account: 기계나 서비스 등 사람이 아닌 클라이언트에 ID를 제공

- Service Account Token

- Service Account마다 자동으로 생성돼 해당 ID claim을 나타냄

- 토큰은 JWT 형식이며 쿠버네티스가 Pod에 주입

- Pod는 이 토큰을 사용해 API 서버에게 (자신의 신원) 인증 가능

- Role 및 ClusterRole: Service Account나 일반 사용자 같은 ID에 대한 권한 집합 정의

- Istiod에 인증과 인가를 제공하는 쿠버네티스 리소스 시각화

istiod의 ID와 접근을 설정하는 리소스 - 클러스터 간 워크로드 디스커버리는 기술적으로 동일하나 다음 과정을 따름 (그림 12.6)

- istiod에 원격 클러스터의 Service Account Token을 및 인증서를 제공해야 함

(인증서 - API 서버로 보안 통신을 시작할 수 있음) - istiod는 토큰을 사용해 원격 클러스터에 인증

- 인증 후 클러스터에서 실행 중인 워크로드 탐색

- istiod에 원격 클러스터의 Service Account Token을 및 인증서를 제공해야 함

- 위 과정은 istioctl이 자동화 해줌

- Istio의 컨트롤 플레인은 쿠버네티스 API 서버와 통신해 서비스 프록시 설정 관련 정보 수집 필요

- 클러스터 간 워크로드 연결 Cross-cluster workload connectivity - Docs : east-west gw or 라우팅 처리

- 전제 조건 2: 워크로드가 클러스터를 건너 연결할 수 있어야 함

- 클러스터가 플랫 네트워크 flat network 에 있을 경우

- flat network 환경:

- 단일 네트워크를 공유 (ex. Amazon VPC)

- 네트워크가 네트워크 피어링 network peering 으로 연결된 경우 등

- 이미 조건 충족: 워크로드가 IP 주소로 연결 할 수 있음

- flat network 환경:

- 클러스터가 서로 다른 네트워크에 있을 경우

- east-west 게이트웨이(특수 Istio 인그레스 게이트웨이) 사용 필요

- 다중 네트워크 메시에서 클러스터를 잇는 인그레스 게이트웨이를 지칭

- 네트워크의 에지에 위치해 클러스터 간 트래픽을 프록시해 줌

east-west 게이트웨이는 각 클러스터의 워크로드에 대한 리버스 프록시 요청을 수행

- east-west 게이트웨이(특수 Istio 인그레스 게이트웨이) 사용 필요

- [공식 문서] Multiple networks 제공 기능 : 중복 IP 환경 시 해결 등 - Docs

- 서비스 엔드포인트의 IP 또는 VIP 범위 중복 Overlapping IP or VIP ranges for service endpoints

- 관리 경계 교차 Crossing of administrative boundaries

- 내결함성 Fault tolerance

- 네트워크 주소 확장 Scaling of network addresses

- 네트워크 분할을 요구하는 표준 준수 Compliance with standards that require network segmentation

- Multi-cluster 에 Multi-primary 환경에서 east-west gateway 없이도, 네트워크 장비에 L3 라우팅을 통해서 통신 가능!

https://www.youtube.com/watch?v=4aeeLGrS514

- 클러스터 간 공통 신뢰 Common trust between clusters - Docs

- 전제 조건 3(마지막): 다중 클러스터 서비스 메시 내 클러스터들이 공통된 신뢰를 가져야 함

- 반대편 클러스터의 워크로드들이 상호 인증할 수 있게 됨

- 반대편 클러스터의 워크로드들이 상호 인증할 수 있게 됨

- 반대편 클러스터의 워크로드들 사이에 공통 신뢰를 달성하는 방법 (두 가지)

- 첫 번째: 공통된 루트 CA가 발급한 사용자 정의 인증서(플러그인 CA 인증서) 를 사용

- 두 번째: 두 클러스터가 인증서를 서명하는 데 사용하는 외부 CA를 통합

- 플러그인 CA 인증서 PLUG-IN CA CERTIFICATES - Docs

같은 루트가 서명한 중간 CA 인증서 사용하기

https://istio.io/v1.17/docs/tasks/security/cert-management/plugin-ca-cert/

Istio에 대한 플러그인 CA로서의 중간 CA

- 플러그인 중간 CA 인증서를 사용하는 방식 (쉬움)

- 중간 CA를 Istio가 만들게 하는 대신에 사용할 인증서를 지정하면 됨

- 이 인증서는 Istio가 설치한 네임스페이스에 시크릿으로 제공

- 두 클러스터 모두에서 인증서를 지정하여, 같은 루트 CA가 서명한 중간 CA를 사용 (그림 12.8)

- 중간 CA를 Istio가 만들게 하는 대신에 사용할 인증서를 지정하면 됨

- 이 방법은 간단하지만, 중간 CA가 노출될 경우 보안 위험 존재

- 노출을 감지해 중간 CA의 인증서를 취소할 때까지 공격자들은 중간 CA로 신뢰받는 인증서 서명 가능

- 보안 취약점으로 인해 조직은 중간 CA를 넘겨주기를(사용하기를) 꺼림

- 중간 CA만 메모리에 로드하고, 이를 Kubernetes Secret(최종: etcd)에 저장하지 않음으로서 노출 위험을 줄일 수 있음

- etcd에 영구 저장을 피할 수 있음

- etcd: Secret과 같은 Kubernetes 리소스가 저장되는 데이터 저장소

- etcd에 영구 저장을 피할 수 있음

- 더 안전한 대안은 인증서에 서명하는 외부 CA를 통합하는 것

- 플러그인 중간 CA 인증서를 사용하는 방식 (쉬움)

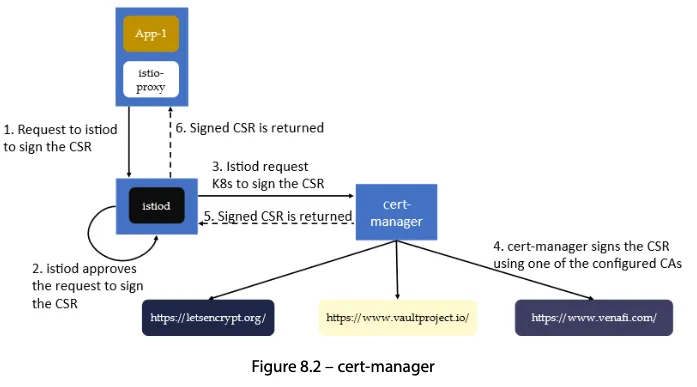

- 외부 인증 기관 통합 EXTERNAL CERTIFICATE AUTHORITY INTEGRATION

- 외부 인증 기관 통합을 사용하는 방식

- istiod는 쿠버네티스 CSR 리소스로 저장된 인증서 서명 요청 CSRs 을 검증하고 승인하는 등록 기관 역할을 함

- 승인된 쿠버네티스 CSR 리소스는 다음 방법 중 하나로 외부 CA에 제출됨

- cert-manager 사용하기 - Github , Home , Docs

- cert-manager 가 우리의 외부 CA를 지원할 때만 가능

- 지원하는 외부 발급자 확인 https://cert-manager.io/docs/configuration/issuers/

- 지원하는 경우

- cert-manager 의 istio-csr로 쿠버네티스 CSR을 지켜봄

- 서명을 위해 외부 CA에 제출

- Istio 에 cert-manager 외부 인증 기간 통합 설정 - Docs , Docs2

Signature Algorithm: ecdsa-with-SHA256 Issuer: O=cert-manager, O=cluster.local, CN=istio-ca Validity Not Before: Jan 13 16:51:59 2022 GMT Not After : Jan 13 17:51:59 2022 GMT ... X509v3 Subject Alternative Name: URI:spiffe://cluster.local/ns/default/sa/httpbin

- cert-manager 가 우리의 외부 CA를 지원할 때만 가능

- 맞춤 개발 Custom development

- cert-manager 사용하기 - Github , Home , Docs

- 외부 인증 기관 통합을 사용하는 방식

- 전제 조건 3(마지막): 다중 클러스터 서비스 메시 내 클러스터들이 공통된 신뢰를 가져야 함

- (참고) Secrets - Docs , Task , Task2 , Task3

- Secret 동작 - 암호화 기본소개

- Secret 데이터는 ETCD에 저장

- Pod에 볼륨 마운트된 Secret 사용 시, 노드 상에 영구적으로 데이터가 남지 않도록 tmpfs 영역(메모리상에 구축된 임시 파일 시스템)에 저장됨

- ETCD에 저장된 Secret 데이터는 암호화되어 있지 않음

- ETCD에 대한 접근 통제와, 암호화를 권장 - Link

- ETCD에 대한 접근 통제와, 암호화를 권장 - Link

- Secret 데이터는 ETCD에 저장

- Secret 볼륨 마운트 실습 : 변경 시 적용되는 동기화 시간 확인

# echo -n 'myusername' | base64 echo -n 'mypassword' | base64 # cat <<EOF | kubectl apply -f - apiVersion: v1 kind: Secret metadata: name: my-secret type: Opaque data: username: bXl1c2VybmFtZQ== password: bXlwYXNzd29yZA== EOF # kubectl get secret my-secret kubectl describe secret my-secret Name: my-secret Namespace: default Labels: <none> Annotations: <none> Type: Opaque Data ==== password: 10 bytes username: 10 bytes # cat <<EOF | kubectl apply -f - apiVersion: v1 kind: Pod metadata: name: secret-volume-demo-pod spec: containers: - name: secret-volume-demo-container image: busybox command: ["sh", "-c", "cat /etc/secret-volume/username; cat /etc/secret-volume/password; sleep 3600"] volumeMounts: - name: secret-volume mountPath: "/etc/secret-volume" readOnly: true volumes: - name: secret-volume secret: secretName: my-secret restartPolicy: Never terminationGracePeriodSeconds: 0 EOF # kubectl get pod # kubectl exec -it secret-volume-demo-pod -- sh --------------------------------------------- # 마운트 정보 확인 df -hT /etc/secret-volume Filesystem Type Size Used Available Use% Mounted on tmpfs tmpfs 15.6G 8.0K 15.6G 0% /etc/secret-volume ... mount -t tmpfs tmpfs on /etc/secret-volume type tmpfs (ro,relatime,size=16360396k) tmpfs on /var/run/secrets/kubernetes.io/serviceaccount type tmpfs (ro,relatime,size=16360396k) ... # 날짜와시간이 포함된 폴더가 있음 ls -al /etc/secret-volume total 4 drwxrwxrwt 3 root root 120 Jul 30 08:13 . drwxr-xr-x 1 root root 4096 Jul 30 08:13 .. drwxr-xr-x 2 root root 80 Jul 30 08:13 ..2024_07_30_08_13_47.2779202592 lrwxrwxrwx 1 root root 32 Jul 30 08:13 ..data -> ..2024_07_30_08_13_47.2779202592 lrwxrwxrwx 1 root root 15 Jul 30 08:13 password -> ..data/password lrwxrwxrwx 1 root root 15 Jul 30 08:13 username -> ..data/username ls -l /etc/secret-volume/..data/ total 8 -rw-r--r-- 1 root root 10 Jul 30 08:13 password -rw-r--r-- 1 root root 10 Jul 30 08:13 username # 파일 정보 확인 cat /etc/secret-volume/..data/username ; echo myusername cat /etc/secret-volume/..data/password ; echo mypassword # 반복 확인 while true ; do ls -al /etc/secret-volume ; echo ; cat /etc/secret-volume/username ; echo ; cat /etc/secret-volume/password ; echo ; date ; echo; sleep 1; done --------------------------------------------- # [터미널2] # Secret 변경 echo -n 'testusername' | base64 echo -n 'testpassword' | base64 cat <<EOF | kubectl apply -f - apiVersion: v1 kind: Secret metadata: name: my-secret type: Opaque data: username: dGVzdHVzZXJuYW1l password: dGVzdHBhc3N3b3Jk EOF date # 결과 확인 : 디렉터리가 신규 생성되고, 심볼릭 링크가 신규 생성된 파일로 링크되며, 기존 폴더는 삭제됨 total 4 drwxrwxrwt 3 root root 120 Jul 30 08:13 . drwxr-xr-x 1 root root 4096 Jul 30 08:13 .. drwxr-xr-x 2 root root 80 Jul 30 08:13 ..2024_07_30_08_13_47.2779202592 lrwxrwxrwx 1 root root 32 Jul 30 08:13 ..data -> ..2024_07_30_08_13_47.2779202592 lrwxrwxrwx 1 root root 15 Jul 30 08:13 password -> ..data/password lrwxrwxrwx 1 root root 15 Jul 30 08:13 username -> ..data/username myusername mypassword Tue Jul 30 08:27:41 UTC 2024 total 4 drwxrwxrwt 3 root root 120 Jul 30 08:27 . drwxr-xr-x 1 root root 4096 Jul 30 08:13 .. drwxr-xr-x 2 root root 80 Jul 30 08:27 ..2024_07_30_08_27_41.2838531760 lrwxrwxrwx 1 root root 32 Jul 30 08:27 ..data -> ..2024_07_30_08_27_41.2838531760 lrwxrwxrwx 1 root root 15 Jul 30 08:13 password -> ..data/password lrwxrwxrwx 1 root root 15 Jul 30 08:13 username -> ..data/username testusername testpassword Tue Jul 30 08:27:42 UTC 2024 # 삭제 kubectl delete pod secret-volume-demo-pod kubectl delete secret my-secret - Hashicorp Vault/VSO on K8S (공개)

- Secret 동작 - 암호화 기본소개

12 .3 다중 클러스터, 다중 네트워크, 다중 컨트롤 플레인 서비스 메시 개요

- 인프라 구성 환경

- 실세계 엔터프라이즈 서비스를 모방하는 인프라 준비

- 서비스 전제 조건

- 여러 클러스터에서 실행

- 여러 리전에 걸쳐 배포

- 서로 다른 네트워크에 위치

- 서비스 상세 구성

- west-cluster : 사설 네트워크가 us-west 리전에 있는 쿠버네티스 클러스터. 여기서 webapp 서비스를 실행

- east-cluster : 사설 네트워크가 us-east 리전에 있는 쿠버네티스 클러스터. 여기서 catalog 서비스를 실행

다중 클러스터 서비스 메시 다이어그램 - 이점

- 클러스터 2개를 서로 다른 2개의 리전에 설정

- 둘 중 하나에 재난이 일어난 경우, 서비스 중단에서 보호 가능

- 여담

- webapp 과 catalog 워크로드가 별개의 클러스터에 있어야 하는 기술적인 이유는 없으며, 단지 시연 상 그리 함

- ‘수다스러운’ 워크로드는 지연 시간을 줄이기 위해 가능하면 가까이 있는 것이 중요

- 다중 클러스터 배포 모델 선택 Choosing the multi-cluster deployment model

- 다중 네트워크 인프라에서 결정할 사항

- 클러스터 사이를 연결할 수 있게 네트워크를 잇는 east-west 게이트웨이를 사용해야 함

- 다만 복제 컨트롤 플레인 배포 모델을 사용할지, 단일 컨트롤 플레인을 사용할지 여부는 정해져 있지 않음

(결정은 비즈니스 요구 사항에 달려 있음)

- 가상 ACME의 서비스 현황

- 온라인 상점이 아주 인기가 많음 (서비스가 중단되는 1분마다 수백만 달러의 비용이 발생)

- 고가용성이 최우선 과제

- 기본-기본 배포 모델 사용: Istio 컨트롤 플레인이 각 클러스터에 배포되게끔 함

- 기본-기본 배포 모델 사용: Istio 컨트롤 플레인이 각 클러스터에 배포되게끔 함

- 종합

- 네트워크를 잇는 east-west 게이트웨이를 사용

- 다중 클러스터, 다중 네트워크, 다중 컨트롤 플레인 서비스 메시를 구축

- 기본-기본 배포 모델 사용

- 다중 네트워크 인프라에서 결정할 사항

- 클라우드 인프라 준비하기 Setting up the cloud infrastructure (실습)

- [실습 환경 구성] k8s(1.23.17) 배포 : west k8s 클러스터 배포 , east k8s 클러스터 배포 - (참고)Github & mypc 컨테이너

- 실습 과정 중 NodePort 사용하는 Service 에서 중복될 수 있음 (중복될 경우, 직접 edit 필요)

- west k8s 클러스터 배포

# kind create cluster --name west --image kindest/node:v1.23.17 --kubeconfig ./west-kubeconfig --config - <<EOF kind: Cluster apiVersion: kind.x-k8s.io/v1alpha4 nodes: - role: control-plane extraPortMappings: - containerPort: 30000 # istio-ingrssgateway HTTP hostPort: 30000 - containerPort: 30001 # Prometheus hostPort: 30001 - containerPort: 30002 # Grafana hostPort: 30002 - containerPort: 30003 # Kiali hostPort: 30003 - containerPort: 30004 # Tracing hostPort: 30004 - containerPort: 30005 # kube-ops-view hostPort: 30005 networking: podSubnet: 10.10.0.0/16 serviceSubnet: 10.100.0.0/24 EOF # 설치 확인 docker ps cat west-kubeconfig kubectl get node --kubeconfig=./west-kubeconfig kubectl get pod -A --kubeconfig=./west-kubeconfig # 노드에 기본 툴 설치 docker exec -it west-control-plane sh -c 'apt update && apt install tree psmisc lsof wget bridge-utils net-tools dnsutils tcpdump ngrep iputils-ping git vim -y' # (옵션) kube-ops-view helm install kube-ops-view geek-cookbook/kube-ops-view --version 1.2.2 --set service.main.type=NodePort,service.main.ports.http.nodePort=30005 --set env.TZ="Asia/Seoul" --namespace kube-system --kubeconfig=./west-kubeconfig kubectl get deploy,pod,svc,ep -n kube-system -l app.kubernetes.io/instance=kube-ops-view --kubeconfig=./west-kubeconfig ## kube-ops-view 접속 URL 확인 open "http://localhost:30005/#scale=1.5" open "http://localhost:30005/#scale=1.3" - east k8s 클러스터 배포

# kind create cluster --name east --image kindest/node:v1.23.17 --kubeconfig ./east-kubeconfig --config - <<EOF kind: Cluster apiVersion: kind.x-k8s.io/v1alpha4 nodes: - role: control-plane extraPortMappings: - containerPort: 31000 # istio-ingrssgateway HTTP hostPort: 31000 - containerPort: 31001 # Prometheus hostPort: 31001 - containerPort: 31002 # Grafana hostPort: 31002 - containerPort: 31003 # Kiali hostPort: 31003 - containerPort: 31004 # Tracing hostPort: 31004 - containerPort: 31005 # kube-ops-view hostPort: 31005 networking: podSubnet: 10.20.0.0/16 serviceSubnet: 10.200.0.0/24 EOF # 설치 확인 docker ps cat east-kubeconfig kubectl get node --kubeconfig=./east-kubeconfig kubectl get pod -A --kubeconfig=./east-kubeconfig # 노드에 기본 툴 설치 docker exec -it east-control-plane sh -c 'apt update && apt install tree psmisc lsof wget bridge-utils net-tools dnsutils tcpdump ngrep iputils-ping git vim -y' # (옵션) kube-ops-view helm install kube-ops-view geek-cookbook/kube-ops-view --version 1.2.2 --set service.main.type=NodePort,service.main.ports.http.nodePort=31005 --set env.TZ="Asia/Seoul" --namespace kube-system --kubeconfig=./east-kubeconfig kubectl get deploy,pod,svc,ep -n kube-system -l app.kubernetes.io/instance=kube-ops-view --kubeconfig=./east-kubeconfig ## kube-ops-view 접속 URL 확인 open "http://localhost:31005/#scale=1.5" open "http://localhost:31005/#scale=1.3" - kind docker network 에 테스트용 PC(실제로는 컨테이너) 배포

# kind 설치 시 kind 이름의 도커 브리지가 생성된다 : 172.18.0.0/16 대역 docker network ls docker inspect kind # mypc 컨테이너 기동 : kind 도커 브리지를 사용하고, 컨테이너 IP를 지정 없이 혹은 지정 해서 사용 docker run -d --rm --name mypc --network kind --ip 172.18.0.100 nicolaka/netshoot sleep infinity # IP 지정 실행 시 혹은 IP 지정 실행 시 에러 발생 시 아래 처럼 IP 지정 없이 실행 docker run -d --rm --name mypc --network kind nicolaka/netshoot sleep infinity # IP 지정 없이 실행 시 docker ps # kind network 중 컨테이너(노드) IP(대역) 확인 docker ps -q | xargs docker inspect --format '{{.Name}} {{.NetworkSettings.Networks.kind.IPAddress}}' /mypc 172.18.0.100 /east-control-plane 172.18.0.3 /west-control-plane 172.18.0.2 # 동일한 docker network(kind) 내부에서 컨테이너 이름 기반 도메인 통신 가능 확인! docker exec -it mypc ping -c 1 172.18.0.2 docker exec -it mypc ping -c 1 172.18.0.3 docker exec -it mypc ping -c 1 west-control-plane docker exec -it mypc ping -c 1 east-control-plane # docker exec -it west-control-plane ping -c 1 east-control-plane docker exec -it east-control-plane ping -c 1 west-control-plane docker exec -it west-control-plane ping -c 1 mypc docker exec -it east-control-plane ping -c 1 mypc

- [실습 환경 구성] (편리성 설정) MetalLB 배포 - Github & Alias 설정(kwest, keast)

- MetalLB 배포

# MetalLB 배포 kubectl apply -f https://raw.githubusercontent.com/metallb/metallb/v0.14.9/config/manifests/metallb-native.yaml \ --kubeconfig=./west-kubeconfig kubectl apply -f https://raw.githubusercontent.com/metallb/metallb/v0.14.9/config/manifests/metallb-native.yaml \ --kubeconfig=./east-kubeconfig # 확인 kubectl get crd --kubeconfig=./west-kubeconfig kubectl get crd --kubeconfig=./east-kubeconfig kubectl get pod -n metallb-system --kubeconfig=./west-kubeconfig kubectl get pod -n metallb-system --kubeconfig=./east-kubeconfig # IPAddressPool, L2Advertisement 설정 cat << EOF | kubectl apply --kubeconfig=./west-kubeconfig -f - apiVersion: metallb.io/v1beta1 kind: IPAddressPool metadata: name: default namespace: metallb-system spec: addresses: - 172.18.255.101-172.18.255.120 --- apiVersion: metallb.io/v1beta1 kind: L2Advertisement metadata: name: default namespace: metallb-system spec: ipAddressPools: - default EOF cat << EOF | kubectl apply --kubeconfig=./east-kubeconfig -f - apiVersion: metallb.io/v1beta1 kind: IPAddressPool metadata: name: default namespace: metallb-system spec: addresses: - 172.18.255.201-172.18.255.220 --- apiVersion: metallb.io/v1beta1 kind: L2Advertisement metadata: name: default namespace: metallb-system spec: ipAddressPools: - default EOF # 확인 kubectl get IPAddressPool,L2Advertisement -A --kubeconfig=./west-kubeconfig kubectl get IPAddressPool,L2Advertisement -A --kubeconfig=./east-kubeconfig - 샘플 애플리케이션 배포 후 확인

# cat << EOF | kubectl apply --kubeconfig=./west-kubeconfig -f - apiVersion: apps/v1 kind: Deployment metadata: name: nginx spec: selector: matchLabels: app: nginx template: metadata: labels: app: nginx spec: containers: - name: nginx image: nginx:latest ports: - containerPort: 80 --- apiVersion: v1 kind: Service metadata: name: nginx-service spec: selector: app: nginx ports: - port: 80 targetPort: 80 type: LoadBalancer EOF # cat << EOF | kubectl apply --kubeconfig=./east-kubeconfig -f - apiVersion: apps/v1 kind: Deployment metadata: name: nginx spec: selector: matchLabels: app: nginx template: metadata: labels: app: nginx spec: containers: - name: nginx image: nginx:latest ports: - containerPort: 80 --- apiVersion: v1 kind: Service metadata: name: nginx-service spec: selector: app: nginx ports: - port: 80 targetPort: 80 type: LoadBalancer EOF # 확인 kubectl get deploy,pod,svc,ep --kubeconfig=./west-kubeconfig kubectl get deploy,pod,svc,ep --kubeconfig=./east-kubeconfig kubectl get svc nginx-service --kubeconfig=./west-kubeconfig -o jsonpath='{.status.loadBalancer.ingress[0].ip}' kubectl get svc nginx-service --kubeconfig=./east-kubeconfig -o jsonpath='{.status.loadBalancer.ingress[0].ip}' WNIP=$(kubectl get svc nginx-service --kubeconfig=./west-kubeconfig -o jsonpath='{.status.loadBalancer.ingress[0].ip}') ENIP=$(kubectl get svc nginx-service --kubeconfig=./east-kubeconfig -o jsonpath='{.status.loadBalancer.ingress[0].ip}') # 외부(mypc)에서 각 클러스터의 Service(LB)로 접속(인입) 확인 : TCP 80 포트 사용으로 편리하다! docker exec -it mypc curl -s $WNIP docker exec -it mypc curl -s $WNIP -v -I docker exec -it mypc curl -s $ENIP docker exec -it mypc curl -s $ENIP -v -I # 확인 후 삭제 kubectl delete deploy,svc --all --kubeconfig=./west-kubeconfig kubectl delete deploy,svc --all --kubeconfig=./east-kubeconfig - alias 설정

# alias kwest='kubectl --kubeconfig=./west-kubeconfig' alias keast='kubectl --kubeconfig=./east-kubeconfig' # 확인 kwest get node keast get node

- MetalLB 배포

- 자주 사용하는 Alias

alias kwest='kubectl --kubeconfig=./west-kubeconfig' alias keast='kubectl --kubeconfig=./east-kubeconfig' alias iwest='docker exec -it west-control-plane istioctl' alias ieast='docker exec -it east-control-plane istioctl'

- [실습 환경 구성] k8s(1.23.17) 배포 : west k8s 클러스터 배포 , east k8s 클러스터 배포 - (참고)Github & mypc 컨테이너

- 플러그인 CA 인증서 설정하기 Configuring plug-in CA certificates

- 9장에서 워크로드 ID를 부트스트래핑(워크로드가 자신의 정체를 입증하는 서명된 인증서를 받는 방법)을 다룰 때

: 설치할 때 인증서에 서명할 CA를 생성한다는 사실을 생략한 바 있음 - 워크로드 ID 부트스트래핑용으로 생성된 CA의 기본 동작

- Istio를 설치한 네임스페이스에 istio-ca-secret 이라는 시크릿으로 저장됨

- istiod 복제본들에게 공유됨

- CA 기본 동작에서 자체 CA를 사용하도록 변경도 가능

- Istio CA가 CA를 새로 만드는 대신, 자체 CA 를 사용

- 자체 CA 사용하도록 변경 시 진행해야 할 사항

- CA 인증서를 Istio를 설치한 네임스페이스인 istio-system 에 cacerts 라는 시크릿으로 저장해야 함

- 다음과 같은 데이터를 포함해야 함

같은 루트가 서명한 중간 CA 인증서 사용하기

- ca.cert.pem : 중간 CA의 인증서

- ca-key.pem : 중간 CA의 개인 키

- root-cert.pem : 중간 CA를 발급한 루트 CA의 인증서

- 루트 CA는 중간 CA들의 인증서를 검증하며, 이것이 클러스터 간 상호 신뢰의 핵심

- cert-chain.pem : 중간 CA의 인증서와 루트 인증서를 이어 붙인 신뢰 체인

- (참고) 인증서 구조

- 루트 CA: 모든 클러스터가 신뢰하는 최상위 인증서.

- 중간 CA: 각 클러스터별로 발급되어 워크로드 인증서 서명에 사용.

- 인증서 체인 : 신뢰 체인을 구성하여 클라이언트가 인증서를 검증할 수 있도록 함.

- (참고) SSL과 인증서 구조 이해하기 : 인증서 계층 구조 설명 - Blog

Geotrust <-> Google CA 예시 (2계층)

Geotrust <-> Google CA <-> 개인 인증서 예시 (3계층) - cacerts 시크릿

- 루트 CA의 공개 키와 중간 CA의 공개 키 및 비밀 키로 구성

- 루트 CA의 비밀 키는 클러스터 외부에 안전하게 저장

cacerts 시크릿은 루트 CA의 공개 키와 중간 CA의 공개 키 및 비밀 키로 구성된다. 루트 CA의 비밀 키는 클러스터 외부에 안전하게 저장된다.

- ./ch12/scripts/generate-certificates.sh 스크립트를 사용 시

- 중간 CA와 루트 CA는 ./ch12/certs 디렉터리에 만들어짐

- 스크립트 실행 시 루트 CA를 만들고, 이 CA를 사용해 중간 CA 2개에 서명

- 그 결과 신뢰가 같은 중간 CA가 만들어짐

- 그 결과 신뢰가 같은 중간 CA가 만들어짐

- 플러그인 CA 인증서 적용하기 APPLYING PLUG-IN CA CERTIFICATES

- ./ch12/scripts/generate-certificates.sh 스크립트 : Smallstep - Github , Install

# cat ./ch12/scripts/generate-certificates.sh #!/bin/bash set -ex cert_dir=`dirname "$BASH_SOURCE"`/../certs echo "Clean up contents of dir './chapter12/certs'" rm -rf ${cert_dir} echo "Generating new certificates" mkdir -p ${cert_dir}/west-cluster mkdir -p ${cert_dir}/east-cluster # step CLI 설치 확인 : step CLI가 설치되어 있지 않으면 에러 출력 후 종료. ## macOS : brew install step if ! [ -x "$(command -v step)" ]; then echo 'Error: Install the smallstep cli (https://github.com/smallstep/cli)' exit 1 fi step certificate create root.istio.in.action ${cert_dir}/root-cert.pem ${cert_dir}/root-ca.key \ --profile root-ca --no-password --insecure --san root.istio.in.action \ --not-after 87600h --kty RSA step certificate create west.intermediate.istio.in.action ${cert_dir}/west-cluster/ca-cert.pem ${cert_dir}/west-cluster/ca-key.pem --ca ${cert_dir}/root-cert.pem --ca-key ${cert_dir}/root-ca.key --profile intermediate-ca --not-after 87600h --no-password --insecure --san west.intermediate.istio.in.action --kty RSA step certificate create east.intermediate.istio.in.action ${cert_dir}/east-cluster/ca-cert.pem ${cert_dir}/east-cluster/ca-key.pem --ca ${cert_dir}/root-cert.pem --ca-key ${cert_dir}/root-ca.key --profile intermediate-ca --not-after 87600h --no-password --insecure --san east.intermediate.istio.in.action --kty RSA cat ${cert_dir}/west-cluster/ca-cert.pem ${cert_dir}/root-cert.pem > ${cert_dir}/west-cluster/cert-chain.pem cat ${cert_dir}/east-cluster/ca-cert.pem ${cert_dir}/root-cert.pem > ${cert_dir}/east-cluster/cert-chain.pem - 기본 정보 확인

# tree ch12/certs ch12/certs ├── east-cluster │ ├── ca-cert.pem # 중간 CA 인증서 │ ├── ca-key.pem # 중간 CA 개인zl │ └── cert-chain.pem # 인증서 체인 ├── root-ca.key # 루트 인증서 ├── root-cert.pem # 루트 개인키 └── west-cluster ├── ca-cert.pem ├── ca-key.pem └── cert-chain.pem # (참고) 인증서 체인 생성 ## 중간 CA 인증서(ca-cert.pem)와 루트 CA 인증서(root-cert.pem)를 결합 -> 결과는 {west/east}-cluster/cert-chain.pem 에 저장 cat ${cert_dir}/west-cluster/ca-cert.pem ${cert_dir}/root-cert.pem > ${cert_dir}/west-cluster/cert-chain.pem cat ${cert_dir}/east-cluster/ca-cert.pem ${cert_dir}/root-cert.pem > ${cert_dir}/east-cluster/cert-chain.pem # 인증서 계층 구조 root.istio.in.action (Root CA) │ └── east.intermediate.istio.in.action (Intermediate CA) # 루트 CA 인증서 확인 openssl x509 -in ch12/certs/root-cert.pem -noout -text ... Issuer: CN=root.istio.in.action Validity Not Before: Jun 28 14:11:35 2022 GMT Not After : Jun 25 14:11:35 2032 GMT Subject: CN=root.istio.in.action ... X509v3 extensions: X509v3 Key Usage: critical Certificate Sign, CRL Sign X509v3 Basic Constraints: critical CA:TRUE, pathlen:1 ... # openssl x509 -in ch12/certs/east-cluster/ca-cert.pem -noout -text ... Issuer: CN=root.istio.in.action Validity Not Before: Jun 28 14:11:35 2022 GMT Not After : Jun 25 14:11:35 2032 GMT Subject: CN=east.intermediate.istio.in.action ... X509v3 extensions: X509v3 Key Usage: critical Certificate Sign, CRL Sign X509v3 Basic Constraints: critical CA:TRUE, pathlen:0 # 이 중간 CA는 추가적인 하위 CA를 만들 수 없음 ... openssl x509 -in ch12/certs/east-cluster/cert-chain.pem -noout -text Issuer: CN=root.istio.in.action Validity Not Before: Jun 28 14:11:35 2022 GMT Not After : Jun 25 14:11:35 2032 GMT Subject: CN=east.intermediate.istio.in.action ... X509v3 extensions: X509v3 Key Usage: critical Certificate Sign, CRL Sign X509v3 Basic Constraints: critical CA:TRUE, pathlen:0 # openssl x509 -in ch12/certs/west-cluster/ca-cert.pem -noout -text openssl x509 -in ch12/certs/west-cluster/cert-chain.pem -noout -text - (옵션) step 로 인증서 생성 시

# step CLI 설치 # macOS : brew install step # 스크립트 실행 ./ch12/scripts/generate-certificates.sh ... # 생성 결과 확인 tree ch12/certs ... - istio-system 네임스페이스를 만든 후 인증서를 cacerts 라는 시크릿으로 배포하여 각 클러스터에 중간 CA를 만들어두기

# west-cluster 용 인증서 설정하기 kwest create namespace istio-system kwest create secret generic cacerts -n istio-system \ --from-file=ch12/certs/west-cluster/ca-cert.pem \ --from-file=ch12/certs/west-cluster/ca-key.pem \ --from-file=ch12/certs/root-cert.pem \ --from-file=ch12/certs/west-cluster/cert-chain.pem # east-cluster 용 인증서 설정하기 keast create namespace istio-system keast create secret generic cacerts -n istio-system \ --from-file=ch12/certs/east-cluster/ca-cert.pem \ --from-file=ch12/certs/east-cluster/ca-key.pem \ --from-file=ch12/certs/root-cert.pem \ --from-file=ch12/certs/east-cluster/cert-chain.pem # 확인 for i in west east; do echo ">> k8s cluster : $i <<"; kubectl get ns istio-system --kubeconfig=./$i-kubeconfig; echo; done for i in west east; do echo ">> k8s cluster : $i <<"; kubectl get secret cacerts -n istio-system --kubeconfig=./$i-kubeconfig; echo; done for i in west east; do echo ">> k8s cluster : $i <<"; kubectl view-secret cacerts -n istio-system --all --kubeconfig=./$i-kubeconfig; echo; done- 플러그인 인증서가 설정되면 Istio 컨트롤 플레인을 설치할 수 있음

- 컨트롤 플레인은 플러그인 CA 인증서(사용자가 정의한 중간 인증서)를 갖고 워크로드 인증서에 서명함

- ./ch12/scripts/generate-certificates.sh 스크립트 : Smallstep - Github , Install

- 9장에서 워크로드 ID를 부트스트래핑(워크로드가 자신의 정체를 입증하는 서명된 인증서를 받는 방법)을 다룰 때

- 각 클러스터에 (Istiod) 컨트롤 플레인 설치하기 Installing the control planes in each cluster

- 들어가며

- 각 클러스터에 네트워크 메타데이터를 설정 (Istio 컨트롤 플레인 설치 전)

- 네트워크 메타데이터 설정에 따른 이점

- Istio에서 토폴로지 정보 사용 가능해짐

- 토폴로지 정보에 기반해 워크로드 설정 가능

- 지역 정보를 사용해 트래픽을 라우팅할 때 가까운 워크로드를 우선할 수 있음

- 워크로드가 다른 네트워크에 있는 원격 클러스터의 워크로드로 트래픽을 라우팅할 때,

east-west 게이트웨이를 사용하도록 Istio 에서 설정함

- 각 클러스터에 네트워크 메타데이터를 설정 (Istio 컨트롤 플레인 설치 전)

- 클러스터 간 연결을 위해 네트워크에 레이블 붙이기 LABELING NETWORKS FOR CROSS-CLUSTER CONNECTIVITY

- 네트워크 토폴로지 설정 - Docs

- Istio 설치 시 MeshNetwork 설정을 사용 (고급 사용 사례에서나 유지하는 레거시 설정)

- Istio를 설치한 네임스페이스에 네트워크 토폴로지 정보를 레이블로 붙이는 것(더 간단한 방법)

- 실습에서는 간단한 방법 사용

- Istio를 설치한 네임스페이스: istio-system

- west-cluster 의 네트워크: west-network

- 따라서 west-cluster 의 istio-system 에 topology.istio.io/network=west-network 레이블 붙이기

(east 도 설정)# kwest label namespace istio-system topology.istio.io/network=west-network keast label namespace istio-system topology.istio.io/network=east-network # 확인 for i in west east; do echo ">> k8s cluster : $i <<"; kubectl get ns istio-system --show-labels --kubeconfig=./$i-kubeconfig; echo; done

- 레이블 사용 시 Istio에서의 효과

- 네트워크 토폴로지를 이해하고, 그 이해를 바탕으로 워크로드 설정법을 결정

- 네트워크 토폴로지를 이해하고, 그 이해를 바탕으로 워크로드 설정법을 결정

- 네트워크 토폴로지 설정 - Docs

- IstioOperator 리소스를 사용해 컨트롤 플레인 설치하기 INSTALLING THE CONTROL PLANES USING ISTIOOPERATOR RESOURCES & Alias 설정(iwest, ieast)

- IstioOperator 리소스를 사용해 west-cluster 의 Istio 설치를 정의 (잦은 수정으로 인해 IstioOperator 사용)

# cat ./ch12/controlplanes/cluster-west.yaml apiVersion: install.istio.io/v1alpha1 kind: IstioOperator metadata: name: istio-controlplane namespace: istio-system spec: profile: demo components: egressGateways: # 이그레스 게이트웨이 비활성화 - name: istio-egressgateway enabled: false values: global: meshID: usmesh # 메시 이름 multiCluster: clusterName: west-cluster # 멀티 클러스터 메시 내부의 클러스터 식별자 network: west-network # 이 설치가 이뤄지는 네트워크

# cat ./ch12/controlplanes/cluster-east.yaml apiVersion: install.istio.io/v1alpha1 kind: IstioOperator metadata: name: istio-controlplane namespace: istio-system spec: profile: demo components: egressGateways: # 이그레스 게이트웨이 비활성화 - name: istio-egressgateway enabled: false values: global: meshID: usmesh # 메시 이름 multiCluster: clusterName: east-cluster network: east-network - west-cluster 를 성공적으로 설치한 후, east-cluster 에 복제한 컨트롤 플레인 설치 가능

# west-control-plane 진입 후 설치 진행 docker exec -it west-control-plane bash ----------------------------------- # istioctl 설치 export ISTIOV=1.17.8 echo 'export ISTIOV=1.17.8' >> /root/.bashrc curl -s -L https://istio.io/downloadIstio | ISTIO_VERSION=$ISTIOV sh - cp istio-$ISTIOV/bin/istioctl /usr/local/bin/istioctl # IstioOperator 파일 작성 cat << EOF > west-istio.yaml apiVersion: install.istio.io/v1alpha1 kind: IstioOperator metadata: name: istio-controlplane namespace: istio-system spec: profile: demo components: egressGateways: - name: istio-egressgateway enabled: false values: global: meshID: usmesh multiCluster: clusterName: west-cluster network: west-network EOF # 컨트롤 플레인 배포 istioctl install -f west-istio.yaml --set values.global.proxy.privileged=true -y # 보조 도구 설치 kubectl apply -f istio-$ISTIOV/samples/addons # 빠져나오기 exit ----------------------------------- # 설치 확인 : istiod, istio-ingressgateway, crd 등 kwest get istiooperators -n istio-system -o yaml ... meshID: usmesh meshNetworks: {} mountMtlsCerts: false multiCluster: clusterName: west-cluster enabled: false network: west-network ... kwest get all,svc,ep,sa,cm,secret,pdb -n istio-system kwest get secret -n istio-system cacerts -o json # 미리 만들어둔 인증서/키 확인 # istio-ingressgateway 서비스 : NodePort 변경 및 nodeport 지정 변경 , externalTrafficPolicy 설정 (ClientIP 수집) kwest patch svc -n istio-system istio-ingressgateway -p '{"spec": {"type": "LoadBalancer", "ports": [{"port": 80, "targetPort": 8080, "nodePort": 30000}]}}' kwest patch svc -n istio-system istio-ingressgateway -p '{"spec":{"externalTrafficPolicy": "Local"}}' kwest describe svc -n istio-system istio-ingressgateway # NodePort 변경 및 nodeport 30001~30003으로 변경 : prometheus(30001), grafana(30002), kiali(30003), tracing(30004) kwest patch svc -n istio-system prometheus -p '{"spec": {"type": "NodePort", "ports": [{"port": 9090, "targetPort": 9090, "nodePort": 30001}]}}' kwest patch svc -n istio-system grafana -p '{"spec": {"type": "NodePort", "ports": [{"port": 3000, "targetPort": 3000, "nodePort": 30002}]}}' kwest patch svc -n istio-system kiali -p '{"spec": {"type": "NodePort", "ports": [{"port": 20001, "targetPort": 20001, "nodePort": 30003}]}}' kwest patch svc -n istio-system tracing -p '{"spec": {"type": "NodePort", "ports": [{"port": 80, "targetPort": 16686, "nodePort": 30004}]}}' # Prometheus 접속 : envoy, istio 메트릭 확인 open http://127.0.0.1:30001 # Grafana 접속 open http://127.0.0.1:30002 # Kiali 접속 : NodePort open http://127.0.0.1:30003 # tracing 접속 : 예거 트레이싱 대시보드 open http://127.0.0.1:30004 - east-cluster 용 IstioOperator 정의는 west-cluster 용과 비교했을 때 클러스터 이름과 네트워크만 다름

- west-cluster 를 설치할 때 사용했던 meshID 를 그대로 지정

(두 컨트롤 플레인의 동일한 메시 형성이 목적이므로 동일한 ID 지정)# west-control-plane 진입 후 설치 진행 docker exec -it east-control-plane bash ----------------------------------- # istioctl 설치 export ISTIOV=1.17.8 echo 'export ISTIOV=1.17.8' >> /root/.bashrc curl -s -L https://istio.io/downloadIstio | ISTIO_VERSION=$ISTIOV sh - cp istio-$ISTIOV/bin/istioctl /usr/local/bin/istioctl # IstioOperator 파일 작성 cat << EOF > east-istio.yaml apiVersion: install.istio.io/v1alpha1 kind: IstioOperator metadata: name: istio-controlplane namespace: istio-system spec: profile: demo components: egressGateways: - name: istio-egressgateway enabled: false values: global: meshID: usmesh multiCluster: clusterName: east-cluster network: east-network EOF # 컨트롤 플레인 배포 istioctl install -f east-istio.yaml --set values.global.proxy.privileged=true -y # 보조 도구 설치 kubectl apply -f istio-$ISTIOV/samples/addons # 빠져나오기 exit ----------------------------------- # 설치 확인 : istiod, istio-ingressgateway, crd 등 keast get istiooperators -n istio-system -o yaml ... meshID: usmesh meshNetworks: {} mountMtlsCerts: false multiCluster: clusterName: east-cluster enabled: false network: east-network ... keast get all,svc,ep,sa,cm,secret,pdb -n istio-system keast get secret -n istio-system cacerts -o json # 미리 만들어둔 인증서/키 확인 # NodePort 변경 및 nodeport 31001~31003으로 변경 : prometheus(31001), grafana(31002), kiali(31003), tracing(31004) keast patch svc -n istio-system prometheus -p '{"spec": {"type": "NodePort", "ports": [{"port": 9090, "targetPort": 9090, "nodePort": 31001}]}}' keast patch svc -n istio-system grafana -p '{"spec": {"type": "NodePort", "ports": [{"port": 3000, "targetPort": 3000, "nodePort": 31002}]}}' keast patch svc -n istio-system kiali -p '{"spec": {"type": "NodePort", "ports": [{"port": 20001, "targetPort": 20001, "nodePort": 31003}]}}' keast patch svc -n istio-system tracing -p '{"spec": {"type": "NodePort", "ports": [{"port": 80, "targetPort": 16686, "nodePort": 31004}]}}' # Prometheus 접속 : envoy, istio 메트릭 확인 open http://127.0.0.1:31001 # Grafana 접속 open http://127.0.0.1:31002 # Kiali 접속 open http://127.0.0.1:31003 # tracing 접속 : 예거 트레이싱 대시보드 open http://127.0.0.1:31004

- west-cluster 를 설치할 때 사용했던 meshID 를 그대로 지정

- istioctl alias 설정 (iwest, ieast) 및 미리 만들어둔 인증서 적용 확인

# docker exec -it west-control-plane istioctl -h docker exec -it east-control-plane istioctl -h # alias iwest='docker exec -it west-control-plane istioctl' alias ieast='docker exec -it east-control-plane istioctl' # iwest proxy-status NAME CLUSTER CDS LDS EDS RDS ECDS ISTIOD VERSION istio-ingressgateway-5db74c978c-9qmt9.istio-system west-cluster SYNCED SYNCED SYNCED NOT SENT NOT SENT istiod-5585445f4c-zf8g6 1.17.8 ieast proxy-status NAME CLUSTER CDS LDS EDS RDS ECDS ISTIOD VERSION istio-ingressgateway-7f6f8f8d99-4mlp5.istio-system east-cluster SYNCED SYNCED SYNCED NOT SENT NOT SENT istiod-85976468f-vp4zg 1.17.8 # iwest proxy-config secret deploy/istio-ingressgateway.istio-system RESOURCE NAME TYPE STATUS VALID CERT SERIAL NUMBER NOT AFTER NOT BEFORE default Cert Chain ACTIVE true 80349990876331570640723939723244297816 2025-05-17T08:47:28Z 2025-05-16T08:45:28Z ROOTCA CA ACTIVE true 100900981840825465297757884708490534092 2032-06-25T14:11:35Z 2022-06-28T14:11:35Z iwest proxy-config secret deploy/istio-ingressgateway.istio-system -o json ... # 아래는 default 에 inlineBytes 값을 decode64 -d 시 3개의 인증서 정보 출력 후 각 개별 인증서를 openssl x509 -in Y.pem -noout -text 로 출력 확인 ## (1) 사용자 인증서 -----BEGIN CERTIFICATE----- MIIDdjCCAl6gAwIBAgIQPHLYaJhiIjAwJkg6cAVeWDANBgkqhkiG9w0BAQsFADAs ... 5xYNi7u0APTzE1swNbx2TF5eeTsFvYcbFh56ahLp0izGkahOv97bEgnZdeTsLRyH K+5+1ZdJ2n8CuxoSY+FXUlMDwGjdvCXAKBM= -----END CERTIFICATE----- Issuer: CN=west.intermediate.istio.in.action Validity Not Before: May 16 08:45:28 2025 GMT Not After : May 17 08:47:28 2025 GMT Subject: ... X509v3 extensions: X509v3 Key Usage: critical Digital Signature, Key Encipherment X509v3 Extended Key Usage: TLS Web Server Authentication, TLS Web Client Authentication X509v3 Basic Constraints: critical CA:FALSE X509v3 Authority Key Identifier: D3:83:9A:3A:51:D9:03:62:35:8F:6A:A4:DA:99:88:BB:74:70:4F:33 X509v3 Subject Alternative Name: critical URI:spiffe://cluster.local/ns/istio-system/sa/istio-ingressgateway-service-account ## (2) 중간 CA 루트 인증서 -----BEGIN CERTIFICATE----- MIIDPDCCAiSgAwIBAgIRAMkJ23sotpqiiWps+38Df/YwDQYJKoZIhvcNAQELBQAw ... usSjiM6KR77xogslodbQw4QQG+w5HQOwMa1k8WTCNrplxdsnaQJjdqUwCdixicq2 DeHuSkz4cykAI/NWc2cZIw== -----END CERTIFICATE----- Issuer: CN=root.istio.in.action Validity Not Before: Jun 28 14:11:35 2022 GMT Not After : Jun 25 14:11:35 2032 GMT Subject: CN=west.intermediate.istio.in.action ... X509v3 extensions: X509v3 Key Usage: critical Certificate Sign, CRL Sign X509v3 Basic Constraints: critical CA:TRUE, pathlen:0 ## (3) 최상위 루트 인증서 -----BEGIN CERTIFICATE----- MIIDDTCCAfWgAwIBAgIQS+jSffZX7itohjyrautczDANBgkqhkiG9w0BAQsFADAf ... 3fRtDApNHbbmi7WXrM+pG4D+Buk2FUEHJVpu16Ch2K2vpRzpkliqes+T/5E92uY9 ob7MBgt61g4VZ/p8+RMJWYw= -----END CERTIFICATE----- Issuer: CN=root.istio.in.action Validity Not Before: Jun 28 14:11:35 2022 GMT Not After : Jun 25 14:11:35 2032 GMT Subject: CN=root.istio.in.action ... X509v3 extensions: X509v3 Key Usage: critical Certificate Sign, CRL Sign X509v3 Basic Constraints: critical CA:TRUE, pathlen:1 # iwest proxy-config listener deploy/istio-ingressgateway.istio-system iwest proxy-config route deploy/istio-ingressgateway.istio-system iwest proxy-config cluster deploy/istio-ingressgateway.istio-system iwest proxy-config endpoint deploy/istio-ingressgateway.istio-system iwest proxy-config secret deploy/istio-ingressgateway.istio-system iwest proxy-config bootstrap deploy/istio-ingressgateway.istio-system iwest proxy-config ecds deploy/istio-ingressgateway.istio-system # ieast proxy-config listener deploy/istio-ingressgateway.istio-system ieast proxy-config route deploy/istio-ingressgateway.istio-system ieast proxy-config cluster deploy/istio-ingressgateway.istio-system ieast proxy-config endpoint deploy/istio-ingressgateway.istio-system ieast proxy-config secret deploy/istio-ingressgateway.istio-system ieast proxy-config bootstrap deploy/istio-ingressgateway.istio-system ieast proxy-config ecds deploy/istio-ingressgateway.istio-system - 두 클러스터 모두에 컨트롤 플레인을 설치하면, 개별 메시 2개를 갖게 됨

- 클러스터 각각에서 개별 메시가 실행하는 것

- 로컬 서비스만 찾는 istiod 복제본 1개

- 수신 트래픽용 게이트웨이 1개

메시에는 현재 다음 절에서 설정할 클러스터 간 워크로드 디스커버리 및 연결이 없음- 이 때 없는 환경에서 각 클러스터에 일부 워크로드를 실행해보기**

(클러스터 간 디스커버리와 연결성이 올바르게 준비됐는지 확인하는 데 유용)

- 이 때 없는 환경에서 각 클러스터에 일부 워크로드를 실행해보기**

- IstioOperator 리소스를 사용해 west-cluster 의 Istio 설치를 정의 (잦은 수정으로 인해 IstioOperator 사용)

- 두 클러스터 모두에 워크로드 실행하기 Running workloads on both clusters

- 컨트롤 플레인을 설치한 상태이니, 이제 몇 가지 워크로드 실행을 해보기

- west-cluster 에서는 webapp 을 배포

# kwest create ns istioinaction kwest label namespace istioinaction istio-injection=enabled kwest -n istioinaction apply -f ch12/webapp-deployment-svc.yaml kwest -n istioinaction apply -f ch12/webapp-gw-vs.yaml kwest -n istioinaction apply -f ch12/catalog-svc.yaml # Stub catalog service to which webapp makes request cat ch12/catalog-svc.yaml piVersion: v1 kind: Service metadata: labels: app: catalog name: catalog spec: ports: - name: http port: 80 protocol: TCP targetPort: 3000 selector: app: catalog # 확인 kwest get deploy,pod,svc,ep -n istioinaction kwest get svc,ep catalog -n istioinaction NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/catalog ClusterIP 10.100.2.43 <none> 80/TCP 2m NAME ENDPOINTS AGE endpoints/catalog <none> 2m kwest get gw,vs,dr -A NAMESPACE NAME AGE istioinaction gateway.networking.istio.io/coolstore-gateway 16s NAMESPACE NAME GATEWAYS HOSTS AGE istioinaction virtualservice.networking.istio.io/webapp-virtualservice ["coolstore-gateway"] ["webapp.istioinaction.io"] 16s # iwest proxy-status NAME CLUSTER CDS LDS EDS RDS ECDS ISTIOD VERSION istio-ingressgateway-5db74c978c-9j96n.istio-system west-cluster SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-5585445f4c-zcvp4 1.17.8 webapp-5c8b4fff64-tfs8m.istioinaction west-cluster SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-5585445f4c-zcvp4 1.17.8 # endpoint 에 IP 는 10.10.0.0/16 대역들 다수 확인 for i in listener route cluster endpoint; do echo ">> k8s cluster : west - istio-config $i <<"; docker exec -it west-control-plane istioctl proxy-config $i deploy/istio-ingressgateway.istio-system; echo; done iwest proxy-config cluster deploy/istio-ingressgateway.istio-system | grep catalog catalog.istioinaction.svc.cluster.local 80 - outbound EDS iwest proxy-config endpoint deploy/istio-ingressgateway.istio-system | grep catalog- east-cluster 에서만 catalog 워크로드(실행 예정) 용 서비스가 필요한 이유는?

- 이 서비스가 없으면 webapp 컨테이너가 FQDN을 IP 주소로 해석할 수 없음

- 따라서 트래픽이 애플리케이션을 떠나 프록시로 리다이렉트되는 지점에 도달하기도 전에 요청이 실패하기 때문

- 이 서비스가 없으면 webapp 컨테이너가 FQDN을 IP 주소로 해석할 수 없음

- 스텁 catalog 서비스를 추가하면 발생하는 현상

- FQDN은 서비스 클러스터 IP로 해석

- 애플리케이션이 트래픽을 시작해 실제 엔보이 설정을 갖음

- 애플리케이션은 클러스터 사이의 라우팅을 처리하는 엔보이 프록시로 리다이렉트될 수 있음

- Istio 향후 버전에서 DNS 프록시를 개선할 때 해결할 예정인 에지 케이스

- east-cluster 에서만 catalog 워크로드(실행 예정) 용 서비스가 필요한 이유는?

- east-cluster 에 catalog 서비스를 배포

# keast create ns istioinaction keast label namespace istioinaction istio-injection=enabled keast -n istioinaction apply -f ch12/catalog.yaml cat ch12/catalog.yaml # 확인 keast get deploy,pod,svc,ep -n istioinaction keast get svc,ep catalog -n istioinaction keast get gw,vs,dr -A # 없음 # ieast proxy-status NAME CLUSTER CDS LDS EDS RDS ECDS ISTIOD VERSION catalog-6cf4b97d-ff7lq.istioinaction east-cluster SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-85976468f-9q8ck 1.17.8 istio-ingressgateway-7f6f8f8d99-fjn92.istio-system east-cluster SYNCED SYNCED SYNCED NOT SENT NOT SENT istiod-85976468f-9q8ck 1.17.8 # endpoint 에 IP 는 10.20.0.0/16 대역들 다수 확인 for i in listener route cluster endpoint; do echo ">> k8s cluster : east - istio-config $i <<"; docker exec -it east-control-plane istioctl proxy-config $i deploy/istio-ingressgateway.istio-system; echo; done ieast proxy-config cluster deploy/istio-ingressgateway.istio-system | grep catalog catalog.istioinaction.svc.cluster.local 80 - outbound EDS ieast proxy-config endpoint deploy/istio-ingressgateway.istio-system | grep catalog 10.20.0.15:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

- 시작점: 클러스터 2개를 각자 연결해야 하는 워크로드가 있는 상태

- 현재 상태로는 클러스터 간 워크로드 디스커버리 없이는 사이드카 프록시에 반대 클러스터의 워크로드가 설정되지 않음

- 다음 단계: 클러스터 간 디스커버리를 활성화

- 들어가며

- 클러스터 간 워크로드 디스커버리 활성화하기 Enabling cross-cluster workload discovery

- 들어가며

- Istio가 원격 클러스터에서 정보를 쿼리하기 위해 인증할 때 필요한 것

- 롤 바인딩 role binding 필요: ID를 정의하는 서비스 어카운트와 권한에 대한 설정

- Istio는 설치 시 istio-reader-service-account 라는 서비스 어카운트를 최소 권한으로 생성

- 다른 컨트롤 플레인이 자신을 인증하고 서비스나 엔드포인트 같은 워크로드 관련 정보를 조회하는 데 사용

- 보안 커넥션 시작할 인증서를 상대 클러스터가 사용하게 하려면?

- 서비스 어카운트 토큰과 원격 클러스터 필요

- 서비스 어카운트 토큰과 원격 클러스터 필요

- Istio가 원격 클러스터에서 정보를 쿼리하기 위해 인증할 때 필요한 것

- 원격 클러스터 접근용 시크릿 만들기 CREATING THE SECRETS FOR REMOTE CLUSTER ACCESS

- istioctl 의 create-remote-secret 명령어 사용 (기본 istio-reader-service-account 서비스 어카운트를 사용)

- 원격 클러스터 접근용으로 시크릿 생성

- 시크릿 생성 시 클러스터 이름을 지정하는 것이 중요 (Istio를 설치할 때 IstioOperator 에서 사용)

- east-cluster 및 west-cluster 값은 앞서 ‘IstioOperator 리소스를 사용해 컨트롤 플레인 설치하기’ 절 참조

- east-cluster 및 west-cluster 값은 앞서 ‘IstioOperator 리소스를 사용해 컨트롤 플레인 설치하기’ 절 참조

- 클러스터 이름이 어떻게 사용되는 지 면밀히 체크 - (클러스터 이름은 원격 클러스터에 접근하기 위한 설정의 식별자)

# for i in west east; do echo ">> k8s cluster : $i <<"; kubectl get sa -n istio-system --kubeconfig=./$i-kubeconfig; echo; done # east keast describe sa -n istio-system istio-reader-service-account ... Mountable secrets: istio-reader-service-account-token-566n2 Tokens: istio-reader-service-account-token-566n2 keast get sa -n istio-system istio-reader-service-account -o yaml ... name: istio-reader-service-account namespace: istio-system resourceVersion: "16805" uid: 40fa07c3-2e49-4003-a09b-afccdbcec7a2 secrets: - name: istio-reader-service-account-token-566n2 keast get sa -n istio-system istio-reader-service-account -o jsonpath='{.secrets[0].name}' eirsa=$(keast get sa -n istio-system istio-reader-service-account -o jsonpath='{.secrets[0].name}') keast get secret -n istio-system $eirsa keast get secret -n istio-system $eirsa -o json { "apiVersion": "v1", "data": { "ca.crt": "LS0t,,,==", "namespace": "aXN0aW8tc3lzdGVt", # istio-system "token": "ZXl...VN2Zw==" }, ... kubectl rolesum istio-reader-service-account -n istio-system --kubeconfig=./east-kubeconfig ... Policies: • [CRB] */istio-reader-clusterrole-istio-system ⟶ [CR] */istio-reader-clusterrole-istio-system Resource Name Exclude Verbs G L W C U P D DC *.[config.istio.io,security.istio.io,networking.istio.io,authentication.istio.io,rbac.istio.io] [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ customresourcedefinitions.apiextensions.k8s.io [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ endpoints [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ endpointslices.discovery.k8s.io [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ namespaces [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ nodes [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ pods [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ replicasets.apps [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ replicationcontrollers [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ secrets [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ serviceexports.multicluster.x-k8s.io [*] [-] [-] ✔ ✔ ✔ ✔ ✖ ✖ ✔ ✖ serviceimports.multicluster.x-k8s.io [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ services [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ subjectaccessreviews.authorization.k8s.io [*] [-] [-] ✖ ✖ ✖ ✔ ✖ ✖ ✖ ✖ tokenreviews.authentication.k8s.io [*] [-] [-] ✖ ✖ ✖ ✔ ✖ ✖ ✖ ✖ workloadentries.networking.istio.io [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ • [CRB] */istio-reader-istio-system ⟶ [CR] */istio-reader-istio-system Resource Name Exclude Verbs G L W C U P D DC *.[config.istio.io,security.istio.io,networking.istio.io,authentication.istio.io,rbac.istio.io] [*] [-] [-] ✔ ✔ ✔ ✖ ✖ ✖ ✖ ✖ ... keast auth can-i --list keast auth can-i --as=system:serviceaccount:istio-system:istio-reader-service-account --list Resources Non-Resource URLs Resource Names Verbs tokenreviews.authentication.k8s.io [] [] [create] selfsubjectaccessreviews.authorization.k8s.io [] [] [create] selfsubjectrulesreviews.authorization.k8s.io [] [] [create] subjectaccessreviews.authorization.k8s.io [] [] [create] serviceexports.multicluster.x-k8s.io [] [] [get list watch create delete] endpoints [] [] [get list watch] namespaces [] [] [get list watch] nodes [] [] [get list watch] pods [] [] [get list watch] replicationcontrollers [] [] [get list watch] secrets [] [] [get list watch] services [] [] [get list watch] ... # ieast x create-remote-secret --help Create a secret with credentials to allow Istio to access remote Kubernetes apiservers ieast x create-remote-secret --name="east-cluster" # This file is autogenerated, do not edit. apiVersion: v1 kind: Secret metadata: annotations: networking.istio.io/cluster: east-cluster creationTimestamp: null labels: istio/multiCluster: "true" # 이 레이블이 true로 설정된 시크릿은 이스티오의 컨트롤 플레인이 새 클러스터를 등록하기 위해 감시한다 name: istio-remote-secret-east-cluster namespace: istio-system stringData: east-cluster: | apiVersion: v1 clusters: - cluster: # 아래 'certificate-authority-data'는 이 클러스터에 보안 커넥션을 시작하는 데 사용하는 CA certificate-authority-data: LS0tLS1CR.... server: https://east-control-plane:6443 name: east-cluster contexts: - context: cluster: east-cluster user: east-cluster name: east-cluster current-context: east-cluster kind: Config preferences: {} users: - name: east-cluster user: # 아래 'token'은 서비스 어카운트의 ID를 나타내는 토큰 token: eyJhb... --- ## certificate-authority-data 정보 : k8s 루트 인증서 openssl x509 -in YYY -noout -text ... Issuer: CN=kubernetes Validity Not Before: May 16 05:13:20 2025 GMT Not After : May 14 05:13:20 2035 GMT Subject: CN=kubernetes ... X509v3 extensions: X509v3 Key Usage: critical Digital Signature, Key Encipherment, Certificate Sign X509v3 Basic Constraints: critical CA:TRUE ## user.token 정보 : jwt decode YYY Token header ------------ { "alg": "RS256", "kid": "oyrLHJhI-1aEvcPmbnFZEI6avASPC3fJttjoEaXt-iU" } Token claims ------------ { "iss": "kubernetes/serviceaccount", "kubernetes.io/serviceaccount/namespace": "istio-system", "kubernetes.io/serviceaccount/secret.name": "istio-reader-service-account-token-566n2", "kubernetes.io/serviceaccount/service-account.name": "istio-reader-service-account", "kubernetes.io/serviceaccount/service-account.uid": "40fa07c3-2e49-4003-a09b-afccdbcec7a2", "sub": "system:serviceaccount:istio-system:istio-reader-service-account" } - 시크릿 내용을 출력하는 대신, kubectl 명령어에 파이프해 west-cluster 에 적용하기

# west 에 시크릿 생성 ieast x create-remote-secret --name="east-cluster" | kwest apply -f - secret/istio-remote-secret-east-cluster created # istiod 로그 확인 : 시크릿이 생성되면, 바로 istiod가 이 시크릿을 가지고 새로 추가된 원격 클러스터(east)에 워크로드를 쿼리한다. kwest logs deploy/istiod -n istio-system | grep 'Adding cluster' 2025-05-16T22:45:00.679666Z info Adding cluster cluster=east-cluster secret=istio-system/istio-remote-secret-east-cluster # for i in west east; do echo ">> k8s cluster : $i <<"; kubectl get secret -n istio-system --kubeconfig=./$i-kubeconfig; echo; done kwest get secret -n istio-system istio-remote-secret-east-cluster kwest get secret -n istio-system istio-remote-secret-east-cluster -o yaml ... # west 확인 : east 의 모든 CDS/EDS 정보를 west 에서도 확인 가능! for i in listener route cluster endpoint; do echo ">> k8s cluster : west - istio-config $i <<"; docker exec -it west-control-plane istioctl proxy-config $i deploy/istio-ingressgateway.istio-system; echo; done iwest proxy-config cluster deploy/istio-ingressgateway.istio-system | grep catalog iwest proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local -o json iwest proxy-config endpoint deploy/istio-ingressgateway.istio-system | grep catalog 10.20.0.15:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local # west 에서 10.20.0.15(10.20.0.0/16)로 라우팅이 가능한 상태인가? iwest proxy-config endpoint deploy/istio-ingressgateway.istio-system --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local' -o json ... "address": { "socketAddress": { "address": "10.20.0.15", "portValue": 3000 ... # east 확인 : west 의 CDS/EDS 정보를 아직 모름! for i in listener route cluster endpoint; do echo ">> k8s cluster : east - istio-config $i <<"; docker exec -it east-control-plane istioctl proxy-config $i deploy/istio-ingressgateway.istio-system; echo; done ieast proxy-config cluster deploy/istio-ingressgateway.istio-system | grep catalog ieast proxy-config endpoint deploy/istio-ingressgateway.istio-system | grep catalog 10.20.0.15:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

- 기본-기본 배포 primary-primary deployment 에서는 east 가 west 쿼리 할 수 있게 반대로도 설정

# east 에 시크릿 생성 iwest x create-remote-secret --name="west-cluster" | keast apply -f - secret/istio-remote-secret-west-cluster created # istiod 로그 확인 : 시크릿이 생성되면, 바로 istiod가 이 시크릿을 가지고 새로 추가된 원격 클러스터(east)에 워크로드를 쿼리한다. keast logs deploy/istiod -n istio-system | grep 'Adding cluster' 2025-05-17T00:09:02.438756Z info Adding cluster cluster=west-cluster secret=istio-system/istio-remote-secret-west-cluster # for i in west east; do echo ">> k8s cluster : $i <<"; kubectl get secret -n istio-system --kubeconfig=./$i-kubeconfig; echo; done keast get secret -n istio-system istio-remote-secret-west-cluster keast get secret -n istio-system istio-remote-secret-west-cluster -o yaml ... # east 확인 : west 의 모든 CDS/EDS 정보를 east 에서도 확인 가능! for i in listener route cluster endpoint; do echo ">> k8s cluster : east - istio-config $i <<"; docker exec -it east-control-plane istioctl proxy-config $i deploy/istio-ingressgateway.istio-system; echo; done ieast proxy-config cluster deploy/istio-ingressgateway.istio-system | grep webapp # east 에서 10.10.0.15(10.10.0.0/16)로 라우팅이 가능한 상태인가? ieast proxy-config endpoint deploy/istio-ingressgateway.istio-system | grep webapp 10.10.0.15:8080 HEALTHY OK outbound|80||webapp.istioinaction.svc.cluster.local

- 기본-기본 배포 primary-primary deployment 에서는 east 가 west 쿼리 할 수 있게 반대로도 설정

- 이제 컨트롤 플레인이 상대 클러스터의 워크로드를 쿼리 가능

# catalog stub service 정보 확인 : endpoints 는 아직도 none. kwest get svc,ep -n istioinaction NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/catalog ClusterIP 10.100.2.43 <none> 80/TCP 14h service/webapp ClusterIP 10.100.2.172 <none> 80/TCP 14h NAME ENDPOINTS AGE endpoints/catalog <none> 14h endpoints/webapp 10.10.0.8:8080 14h # webapp stub service 생성하지 않았으므로 별도 west 의 webapp service 정보가 없다 keast get svc,ep -n istioinaction NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/catalog ClusterIP 10.200.3.0 <none> 80/TCP 14h NAME ENDPOINTS AGE endpoints/catalog 10.20.0.8:3000 14h

- istioctl 의 create-remote-secret 명령어 사용 (기본 istio-reader-service-account 서비스 어카운트를 사용)

- 다음: 클러스터 간 연결 설정

- 들어가며

- 클러스터 간 연결 설정하기 Setting up cross-cluster connectivity

- 들어가며 : north-south 트래픽, east-west 트래픽

- Istio의 인그레스 게이트웨이는 엔보이 프록시 기반

- 트래픽 유형

- north-south 트래픽: 기본적인 트래픽 유형. 인그레스 게이트웨이는 퍼블릭 네트워크에서 시작한 트래픽의 진입점으로, 트래픽을 조직의 내부 네트워크로 보냄

- east-west 트래픽 (그림 12.12 참조) : 서로 다른 내부 네트워크(여기서는 클러스터의 네트워크) 간의 트래픽

north-south 와 east-west 트래픽

- east-west 트래픽을 단순화하기 위한 클라우드 프로바이더 동작

- 네트워크 주소 공간이 겹치지 않는다면 가상 네트워크의 피어링을 활성화

- 피어링된 가상 네트워크의 서비스들은 IPv4 및 IPv6 주소로 직접 커넥션 시작

- east-west 게이트웨이를 사용하는 이유

- 네트워크 피어링은 클라우드 전용 기능

- 네트워크 피어링이 불가능한, 다른 클라우드 프로바이더나 온프레미스에 있는 클러스터에 연결하고 싶을 때 Istio가 제공하는 기능

- east-west 게이트웨이 사용 방식

- 반대편 클러스터 워크로드에 접근 가능한 로드 밸런서로 노출하여 사용

- 반대편 클러스터 워크로드에 접근 가능한 로드 밸런서로 노출하여 사용

- Istio의 east-west 게이트웨이 ISTIO’S EAST-WEST GATEWAY

- east-west 게이트웨이 목적

- 클러스터 간 east-west 트래픽의 진입점 역할

- 트래픽 진입 과정을 서비스 운영 팀에게 투명하게 만드는 것

- east-west 게이트웨이에서 목적을 달성하기 위해 수행해야 할 것 (필수)

- 클러스터 사이의 정밀한 트래픽 관리

- 암호화된 트래픽 라우팅

: 암호화된 상태로 라우팅해야 워크로드 간 상호 인증이 가능

- east-west 게이트웨이 구성 후 추가 리소스가 필요한가?

- 서비스 메시 운영자는 어떤 추가 리소스도 구성할 필요가 없어야 함

(즉, 어떤 이스티오 리소스도 추가 구성할 필요가 없어야 함)

- 서비스 메시 운영자는 어떤 추가 리소스도 구성할 필요가 없어야 함

- east-west 게이트웨이 구성 시

- 트래픽을 클러스터 내에서 라우팅할 때나, 클러스터 간에 라우팅할 때 차이가 없음

- 트래픽을 클러스터 내에서 라우팅할 때나, 클러스터 간에 라우팅할 때 차이가 없음

- 클러스터 간 연결 (north-south 트래픽, east-west 트래픽) 에서 가능한 것

- 워크로드는 서비스를 세밀하게 겨냥할 수 있음

- 상호 인증된 커넥션 시작 가능

- 클러스터 간 연결 구현의 이해를 위한 Istio 기능 (2가지)

- SNI 클러스터

- SNI 자동 통과

- east-west 게이트웨이 목적

- SNI 클러스터로 east-west 게이트웨이 설정하기 CONFIGURING EAST-WEST GATEWAYS WITH SNI CLUSTERS

- east-west 게이트웨이: SNI 클러스터를 모든 서비스에 추가 설정한 인그레스 게이트웨이

- SNI 클러스터

- 단순히 보통의 엔보이 클러스터 Envoy clusters 같은 것

(10장 10.3.2절의 ‘엔보이 클러스터 설정 쿼리하기’ 절 참조) - 트래픽이 라우팅될 수 있는 유사 워크로드 집합을 묶는 속성인 방향, 부분집합, 포트, FQDN을 포함

- 단순히 보통의 엔보이 클러스터 Envoy clusters 같은 것

- 엔보이 클러스터와 SNI 클러스터의 주요 차이점

- SNI 클러스터는 모든 엔보이 클러스터 정보를 SNI에 인코딩

- SNI 클러스터 인코딩의 효과

- east-west 게이트웨이는 클러스터가 SNI 안에 지정한 클러스터로 암호화된 트래픽을 라우팅할 수 있음

- ex) 클라이언트(webapp 같은)가 원격 클러스터의 워크로드(catalog 같은)로 커넥션을 시작할 때 겨냥하는 클러스터를 SNI에 인코딩 (그림 12.13)

- 클러스터 정보는 SNI에 인코딩된다.

- SNI에는 라우팅 결정을 지시하는 방향, 포트, 버전, 서비스 이름이 포함된다.

- ex) 클라이언트(webapp 같은)가 원격 클러스터의 워크로드(catalog 같은)로 커넥션을 시작할 때 겨냥하는 클러스터를 SNI에 인코딩 (그림 12.13)

- 암호화된 트래픽 라우팅을 통해

- 클라이언트는 세밀한 라우팅 결정을 내릴 수 있음

- 게이트웨이는 SNI 헤더에서 클러스터 정보를 읽어 트래픽을 클라이언트가 의도한 워크로드로 프록시할 수 있음

- 이 모든 작업이 안전하고 상호 인증한 커넥션을 워크로드 사이에 유지하는 중에 일어남

- east-west 게이트웨이는 클러스터가 SNI 안에 지정한 클러스터로 암호화된 트래픽을 라우팅할 수 있음

- east-west 게이트웨이: SNI 클러스터를 모든 서비스에 추가 설정한 인그레스 게이트웨이

- SNI 클러스터가 있는 east-west 게이트웨이 설치하기 Installing the east-west gateway with SNI clusters

- SNI 클러스터 설정은 옵트인 기능으로, 다음 IstioOpertor 정의처럼 환경 변수 ISTIO_META_ROUTER_MODE 로 게이트웨이 라우터 모드를 sni-dnat 으로 설정해서 활성화할 수 있음

# cat ch12/gateways/cluster-east-eastwest-gateway.yaml apiVersion: install.istio.io/v1alpha1 kind: IstioOperator metadata: name: istio-eastwestgateway # IstioOperator 이름은 앞 선 이스티오 설정 이름과 겹치지 않아야 한다 namespace: istio-system spec: profile: empty # empty 프로필은 추가 이스티오 구성 요소를 설치하지 않는다 components: ingressGateways: - name: istio-eastwestgateway # 게이트웨이 이름 label: istio: eastwestgateway app: istio-eastwestgateway topology.istio.io/network: east-network enabled: true k8s: env: - name: ISTIO_META_ROUTER_MODE # sni-dnat 모드는 트래픽을 프록시하는 데 필요한 SNI 클러스터를 추가한다 value: "sni-dnat" # The network to which traffic is routed - name: ISTIO_META_REQUESTED_NETWORK_VIEW # 게이트웨이가 트래픽을 라우팅하는 네트워크 value: east-network service: ports: ... (생략) ... values: global: meshID: usmesh # 메시, 클러스터, 네트워크 식별 정보 multiCluster: clusterName: east-cluster network: east-network

- IstioOperator 리소스 이름 설정 시 주의사항

- 처음에 컨트롤 플레인 설치하는 데 사용한 리소스와 같으면 안 됨

(같은 이름을 사용하면 앞 서 설치한 것을 덮어 씀)

- 처음에 컨트롤 플레인 설치하는 데 사용한 리소스와 같으면 안 됨

- ISTIO_META_ROUTER_MODE 를 sni-dnat 으로 설정하면

- SNI 클러스터를 자동으로 구성함

- 지정하지 않으면 standard 모드로 돌아가며, 이는 SNI 클러스터를 설정하지 않음

- ISTIO_META_REQUESTED_NETWORK_VIEW

- 네트워크 트래픽이 프록시되는 곳을 정의

- 네트워크 트래픽이 프록시되는 곳을 정의

- IstioOperator 리소스 이름 설정 시 주의사항

- IstioOperator 로 east 클러스터에 east-west 게이트웨이를 설치

# 설치 전 확인 for i in west east; do echo ">> k8s cluster : $i <<"; kubectl get pod -n istio-system -l istio.io/rev=default --kubeconfig=./$i-kubeconfig; echo; done for i in west east; do echo ">> k8s cluster : $i <<"; kubectl get IstioOperator -n istio-system --kubeconfig=./$i-kubeconfig; echo; done kwest get IstioOperator -n istio-system installed-state-istio-controlplane -o yaml keast get IstioOperator -n istio-system installed-state-istio-controlplane -o yaml # 설치 전 확인 : west 에서 catalog endpoint 에 IP 확인 for i in listener route cluster endpoint; do echo ">> k8s cluster : west - istio-config $i <<"; docker exec -it west-control-plane istioctl proxy-config $i deploy/istio-ingressgateway.istio-system; echo; done iwest proxy-config endpoint deploy/istio-ingressgateway.istio-system | grep catalog 10.20.0.15:3000 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local # IstioOperator 로 east 클러스터에 east-west 게이트웨이를 설치 cat ch12/gateways/cluster-east-eastwest-gateway.yaml docker cp ./ch12/gateways/cluster-east-eastwest-gateway.yaml east-control-plane:/cluster-east-eastwest-gateway.yaml ieast install -f /cluster-east-eastwest-gateway.yaml --set values.global.proxy.privileged=true -y # east 클러스터에 east-west 게이트웨이를 설치 확인 for i in west east; do echo ">> k8s cluster : $i <<"; kubectl get IstioOperator -n istio-system --kubeconfig=./$i-kubeconfig; echo; done for i in west east; do echo ">> k8s cluster : $i <<"; kubectl get pod -n istio-system -l istio.io/rev=default --kubeconfig=./$i-kubeconfig; echo; done ... NAME READY STATUS RESTARTS AGE istio-eastwestgateway-866794c798-k9xfl 1/1 Running 0 14s istio-ingressgateway-7f6f8f8d99-4mlp5 1/1 Running 1 (3h38m ago) 17h istiod-85976468f-vp4zg 1/1 Running 1 (3h38m ago) 17h keast get IstioOperator -n istio-system installed-state-istio-eastwestgateway -o yaml ... ingressGateways: - enabled: true k8s: env: - name: ISTIO_META_ROUTER_MODE value: sni-dnat - name: ISTIO_META_REQUESTED_NETWORK_VIEW value: east-network service: ports: - name: status-port port: 15021 targetPort: 15021 - name: mtls port: 15443 targetPort: 15443 - name: tcp-istiod port: 15012 targetPort: 15012 - name: tcp-webhook port: 15017 targetPort: 15017 label: app: istio-eastwestgateway istio: eastwestgateway topology.istio.io/network: east-network name: istio-eastwestgateway ... # east 정보 확인 ieast proxy-status NAME CLUSTER CDS LDS EDS RDS ECDS ISTIOD VERSION catalog-6cf4b97d-9c995.istioinaction east-cluster SYNCED SYNCED SYNCED SYNCED NOT SENT istiod-85976468f-vp4zg 1.17.8 istio-eastwestgateway-866794c798-k9xfl.istio-system east-cluster SYNCED SYNCED SYNCED NOT SENT NOT SENT istiod-85976468f-vp4zg 1.17.8 istio-ingressgateway-7f6f8f8d99-4mlp5.istio-system east-cluster SYNCED SYNCED SYNCED NOT SENT NOT SENT istiod-85976468f-vp4zg 1.17.8 # east 에 istio-ingressgateway 에 istio-config 정보 확인 : west 의 CDS/EDS 모두 알고 있음! for i in listener route cluster endpoint; do echo ">> east k8s cluster : ingressgateway - istio-config $i <<"; docker exec -it east-control-plane istioctl proxy-config $i deploy/istio-ingressgateway.istio-system; echo; done # east 에 istio-eastwestgateway 에 istio-config 정보 확인 : webapp(CDS) OK, west 에 EDS 아직 모름! for i in listener route cluster endpoint; do echo ">> east k8s cluster : eastwestgateway - istio-config $i <<"; docker exec -it east-control-plane istioctl proxy-config $i deploy/istio-eastwestgateway.istio-system; echo; done ieast proxy-config cluster deploy/istio-eastwestgateway.istio-system | grep istioinaction catalog.istioinaction.svc.cluster.local 80 - outbound EDS webapp.istioinaction.svc.cluster.local 80 - outbound EDS ieast proxy-config cluster deploy/istio-eastwestgateway.istio-system --fqdn webapp.istioinaction.svc.cluster.local -o json ieast proxy-config cluster deploy/istio-eastwestgateway.istio-system --fqdn webapp.istioinaction.svc.cluster.local -o json | grep sni "sni": "outbound_.80_._.webapp.istioinaction.svc.cluster.local" ieast proxy-config endpoint deploy/istio-eastwestgateway.istio-system | grep istioinaction ieast proxy-config endpoint deploy/istio-eastwestgateway.istio-system --cluster 'outbound|80||catalog.istioinaction.svc.cluster.local' -o json # west 정보 확인 iwest proxy-status # west 에 istio-ingressgateway 에 istio-config 정보 확인 for i in listener route cluster endpoint; do echo ">> west k8s cluster : ingressgateway - istio-config $i <<"; docker exec -it west-control-plane istioctl proxy-config $i deploy/istio-ingressgateway.istio-system; echo; done iwest proxy-config cluster deploy/istio-ingressgateway.istio-system | grep istioinaction iwest proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local -o json iwest proxy-config cluster deploy/istio-ingressgateway.istio-system --fqdn catalog.istioinaction.svc.cluster.local -o json | grep sni "sni": "outbound_.80_._.catalog.istioinaction.svc.cluster.local" # west 에 istio-ingressgateway : east EDS 모든 정보에서 east의 eastwestgateway에 mtls 정보로 변경! iwest proxy-config endpoint deploy/istio-ingressgateway.istio-system | grep istioinaction 10.10.0.15:8080 HEALTHY OK outbound|80||webapp.istioinaction.svc.cluster.local 172.18.255.202:15443 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local # 출력되는 172.18.X.Y에 IP 확인 : east 에 eastwestgateway 의 Service(LoadBalancer)의 External-IP. keast get svc,ep -n istio-system istio-eastwestgateway NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/istio-eastwestgateway LoadBalancer 10.200.0.90 172.18.255.202 15021:32281/TCP,15443:30196/TCP,15012:32628/TCP,15017:32346/TCP 27m NAME ENDPOINTS AGE endpoints/istio-eastwestgateway 10.20.0.16:15021,10.20.0.16:15017,10.20.0.16:15012 + 1 more... 27m # west 에 webapp 에 istio-config 정보 확인 for i in listener route cluster endpoint; do echo ">> west k8s cluster : webapp - istio-config $i <<"; docker exec -it west-control-plane istioctl proxy-config $i deploy/webapp.istioinaction; echo; done iwest proxy-config endpoint deploy/webapp.istioinaction | grep istioinaction 10.10.0.15:8080 HEALTHY OK outbound|80||webapp.istioinaction.svc.cluster.local 172.18.255.202:15443 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local # west 에서 호출 시도 kwest get svc,ep -n istioinaction NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/catalog ClusterIP 10.100.0.170 <none> 80/TCP 63m service/webapp ClusterIP 10.100.0.141 <none> 80/TCP 63m NAME ENDPOINTS AGE endpoints/catalog <none> 63m endpoints/webapp 10.10.0.15:8080 63m kwest exec -it deploy/webapp -c istio-proxy -n istioinaction -- curl catalog.istioinaction.svc.cluster.local -v * Trying 10.100.0.170:80... * connect to 10.100.0.170 port 80 failed: Connection refused ...

- east-west 게이트웨이를 설치하고 라우터 모드를 sni-dnat으로 설정한 후 진행할 다음 단계

- SNI 자동 통과 모드 SNI auto passthrough mode 를 사용해 east-west 게이트웨이에서 다중 클러스터 상호 TLS 포트를 노출하기

- Istio는 영리해서, 딱 그때만 게이트웨이에 SNI 클러스터를 설정

- east-west 게이트웨이를 설치하고 라우터 모드를 sni-dnat으로 설정한 후 진행할 다음 단계

- SNI 클러스터 설정은 옵트인 기능으로, 다음 IstioOpertor 정의처럼 환경 변수 ISTIO_META_ROUTER_MODE 로 게이트웨이 라우터 모드를 sni-dnat 으로 설정해서 활성화할 수 있음

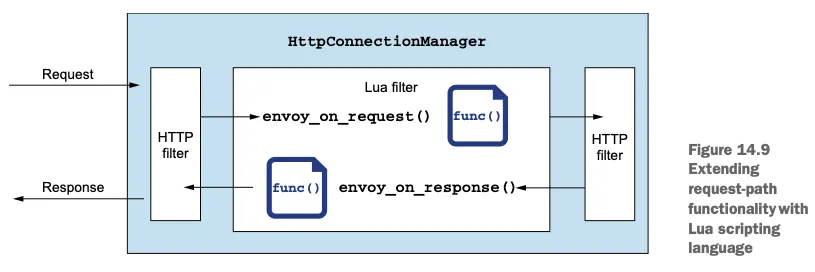

- SNI 자동 통과로 클러스터 간 트래픽 라우팅하기 ROUTING CROSS-CLUSTER TRAFFIC USING SNI AUTO PASSTHROUGH

- SNI 자동 통과 auto passthrough 이해를 돕는 사항

- 수동 SNI 통과가 SNI 헤더에 기반해 트래픽을 허용하도록 인그레스 게이트웨이를 설정한다는 것 (4장의 4.4.2절 참고)

- 이같은 사실은 허용된 트래픽을 라우팅하려면 서비스 운영자가 수작업으로 VirtualService 리소스를 정의해야 함을 보여줌

SNI 자동 통과 auto passthrough 로 트래픽을 라우팅하려면 VirtualService 리소스를 정의하는 것이 필수

- SNI 자동 통과란

- 이름과 같이, 허용된 트래픽을 라우팅하자고 VirtualService 를 수작업으로 만들 필요가 없음

- 라우팅은 SNI 클러스터를 사용해 수행할 수 있음

- SNI 클러스터는 라우터 모드가 sni-dnat 일때 east-west 게이트웨이에서 자동으로 설정됨

SNI 자동 통과를 통한 트래픽 라우팅은 sni-dnat 라우터 모드에서 초기화된 SNI 클러스터를 사용

- SNI 클러스터는 라우터 모드가 sni-dnat 일때 east-west 게이트웨이에서 자동으로 설정됨

- SNI 자동 통과는 Istio Gateway 리소스로 설정 가능

- 다음 정의에서는 SNI 헤더의 값이 *.local 인 모든 트래픽에 대해 SNI 자동 통과를 사용함

(이는 모든 쿠버네티스 서비스에 해당)# cat ch12/gateways/expose-services.yaml apiVersion: networking.istio.io/v1alpha3 kind: Gateway metadata: name: cross-network-gateway namespace: istio-system spec: selector: istio: eastwestgateway # 셀렉터와 일치하는 게이트웨이에만 설정이 적용된다. servers: - port: number: 15443 # 이스티오에서 15443 포트는 멀티 클러스터 상호 TLS 트래픽 용도로 지정된 특수 포트다 name: tls protocol: TLS tls: mode: AUTO_PASSTHROUGH # SNI 헤더를 사용해 목적지를 해석하고 SNI 클러스터를 사용한다. hosts: - "*.local" # 정규식 *.local 과 일치하는 SNI에 대해서만 트래픽을 허용한다.

- 다음 정의에서는 SNI 헤더의 값이 *.local 인 모든 트래픽에 대해 SNI 자동 통과를 사용함

- east 클러스터에 적용 시: east-cluster의 워크로드를 west-cluster 에 노출

# east 클러스터에 적용하자. east-cluster의 워크로드를 west-cluster 에 노출한다. cat ch12/gateways/expose-services.yaml keast apply -n istio-system -f ch12/gateways/expose-services.yaml # 확인 keast get gw,vs,dr -A NAMESPACE NAME AGE istio-system gateway.networking.istio.io/cross-network-gateway 85s # west 에서 호출 시도 kwest get svc,ep -n istioinaction NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/catalog ClusterIP 10.100.0.170 <none> 80/TCP 63m service/webapp ClusterIP 10.100.0.141 <none> 80/TCP 63m NAME ENDPOINTS AGE endpoints/catalog <none> 63m endpoints/webapp 10.10.0.15:8080 63m kwest exec -it deploy/webapp -c istio-proxy -n istioinaction -- curl catalog.istioinaction.svc.cluster.local -v * Trying 10.100.0.170:80... * connect to 10.100.0.170 port 80 failed: Connection refused ... # east 에 istio-ingressgateway 에 istio-config 정보 확인 : 이전 내용과 동일하게 west 의 CDS/EDS 모두 알고 있음! for i in listener route cluster endpoint; do echo ">> east k8s cluster : ingressgateway - istio-config $i <<"; docker exec -it east-control-plane istioctl proxy-config $i deploy/istio-ingressgateway.istio-system; echo; done # east 에 istio-eastwestgateway 에 istio-config 정보 확인 : SNI 자동 통과를 위한 listener 추가 확인! for i in listener route cluster endpoint; do echo ">> east k8s cluster : eastwestgateway - istio-config $i <<"; docker exec -it east-control-plane istioctl proxy-config $i deploy/istio-eastwestgateway.istio-system; echo; done ieast proxy-config listener deploy/istio-eastwestgateway.istio-system ieast proxy-config listener deploy/istio-eastwestgateway.istio-system | grep istioinaction 0.0.0.0 15443 SNI: outbound_.80_._.webapp.istioinaction.svc.cluster.local; App: istio,istio-peer-exchange,istio-http/1.0,istio-http/1.1,istio-h2 Cluster: outbound_.80_._.webapp.istioinaction.svc.cluster.local 0.0.0.0 15443 SNI: outbound_.80_._.catalog.istioinaction.svc.cluster.local; App: istio,istio-peer-exchange,istio-http/1.0,istio-http/1.1,istio-h2 Cluster: outbound_.80_._.catalog.istioinaction.svc.cluster.local ieast proxy-config listener deploy/istio-eastwestgateway.istio-system --port 15443 -o json ... "filterChainMatch": { "serverNames": [ "outbound_.80_._.catalog.istioinaction.svc.cluster.local" ... }, "filters": [ ... { "name": "envoy.filters.network.tcp_proxy", "typedConfig": { "@type": "type.googleapis.com/envoy.extensions.filters.network.tcp_proxy.v3.TcpProxy", "statPrefix": "outbound_.80_._.catalog.istioinaction.svc.cluster.local", "cluster": "outbound_.80_._.catalog.istioinaction.svc.cluster.local", ... # west 정보 확인 iwest proxy-status # west 에 istio-ingressgateway 에 istio-config 정보 확인 for i in listener route cluster endpoint; do echo ">> west k8s cluster : ingressgateway - istio-config $i <<"; docker exec -it west-control-plane istioctl proxy-config $i deploy/istio-ingressgateway.istio-system; echo; done # west 에 webapp 에 istio-config 정보 확인 for i in listener route cluster endpoint; do echo ">> west k8s cluster : webapp - istio-config $i <<"; docker exec -it west-control-plane istioctl proxy-config $i deploy/webapp.istioinaction; echo; done - 반대편 클러스터에도 작업 수행: west-cluster 에 east-west 게이트웨이를 만들고, 그 서비스를 east-cluster 워크로드에 노출

# IstioOperator 로 west 클러스터에 east-west 게이트웨이를 설치 cat ch12/gateways/cluster-west-eastwest-gateway.yaml docker cp ./ch12/gateways/cluster-west-eastwest-gateway.yaml west-control-plane:/cluster-west-eastwest-gateway.yaml iwest install -f /cluster-west-eastwest-gateway.yaml --set values.global.proxy.privileged=true -y # west 클러스터에 east-west 게이트웨이를 설치 확인 for i in west east; do echo ">> k8s cluster : $i <<"; kubectl get IstioOperator -n istio-system --kubeconfig=./$i-kubeconfig; echo; done for i in west east; do echo ">> k8s cluster : $i <<"; kubectl get pod -n istio-system -l istio.io/rev=default --kubeconfig=./$i-kubeconfig; echo; done kwest get IstioOperator -n istio-system installed-state-istio-eastwestgateway -o yaml iwest proxy-status # west 클러스터에 적용하자. east-cluster의 워크로드를 west-cluster 에 노출한다. cat ch12/gateways/expose-services.yaml kwest apply -n istio-system -f ch12/gateways/expose-services.yaml # 확인 kwest get gw,vs,dr -A NAMESPACE NAME AGE istio-system gateway.networking.istio.io/cross-network-gateway 5s istioinaction gateway.networking.istio.io/coolstore-gateway 89m NAMESPACE NAME GATEWAYS HOSTS AGE istioinaction virtualservice.networking.istio.io/webapp-virtualservice ["coolstore-gateway"] ["webapp.istioinaction.io"] 89m kwest get svc,ep -n istioinaction NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/catalog ClusterIP 10.100.0.170 <none> 80/TCP 93m service/webapp ClusterIP 10.100.0.141 <none> 80/TCP 93m NAME ENDPOINTS AGE endpoints/catalog <none> 93m endpoints/webapp 10.10.0.15:8080 93m ieast pc clusters deploy/istio-eastwestgateway.istio-system | grep catalog catalog.istioinaction.svc.cluster.local 80 - outbound EDS outbound_.80_._.catalog.istioinaction.svc.cluster.local - - - EDS # sni 클러스터 확인 ieast pc clusters deploy/istio-eastwestgateway.istio-system | grep catalog | awk '{printf "CLUSTER: %s\n", $1}' CLUSTER: catalog.istioinaction.svc.cluster.local CLUSTER: outbound_.80_._.catalog.istioinaction.svc.cluster.local # catalog 서비스용 SNI 클러스터 - 출력에서 알 수 있는 것

- catalog 워크로드에 SNI 클러스터가 정의됐음을 보여줌

- SNI 자동 통과로 게이트웨이를 설정한 효과

- 게이트웨이에 들어오는 트래픽은 SNI 클러스터를 사용해 의도한 워크로드로 라우팅

- Istio 컨트롤 플레인은 이 리소스들의 생성을 지켜보고 있다가, 이제 클러스터 간 트래픽을 라우팅할 수 있는 경로가 존재함을 발견

- 따라서 컨트롤 플레인은 원격 클러스터에서 새로 발견한 엔드포인트로 모든 워크로드를 설정함

- 클러스터 간 워크로드 디스커버리 검증하기 VALIDATING CROSS-CLUSTER WORKLOAD DISCOVERY

- 앞서 east-cluster 의 워크로드가 west-cluster 에 노출됨

- webapp 엔보이 클러스터가 catalog 워크로드로 향햐는 엔드포인트를 갖고 있을 것

- 이 엔드포인트는 네트워크의 catalog 에 대한 요청을 프록시하는 east-west 게이트웨이 주소를 가리켜야 함

- east-cluster 의 east-west 게이트웨이 주소(Service)를 알아보기

# keast -n istio-system get svc istio-eastwestgateway -o jsonpath='{.status.loadBalancer.ingress[0].ip}' 172.18.255.202 - 위 값을 west-cluster 의 워크로드가 클러스터 간 트래픽을 라우팅할 때 사용하는 주소와 비교

# iwest pc endpoints deploy/webapp.istioinaction | grep catalog 172.18.255.202:15443 HEALTHY OK outbound|80||catalog.istioinaction.svc.cluster.local

카탈로그 엔드포인트는 east-west 게이트웨이 멀티 클러스터 포트를 참조 - catalog 리소스의 엔드포인트가 east-west 게이트웨이의 주소와 일치하면, 워크로드를 찾을 수 있고 클러스터 간 트래픽이 가능

- 프록시 설정을 고려하면 모든 것이 올바르게 설정됨

- 직접 요청을 트리거하여 확인

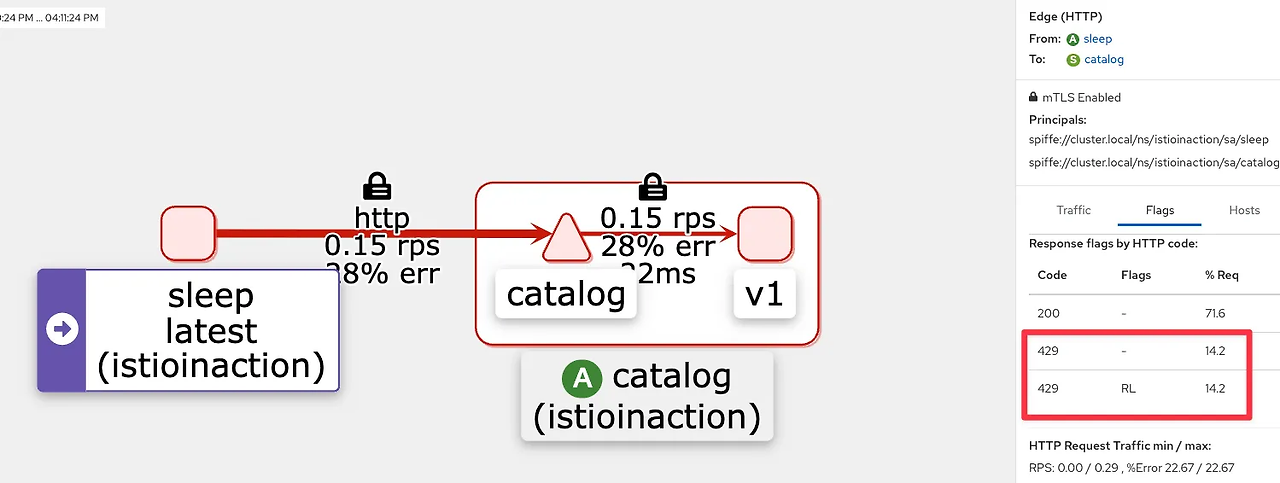

# west 에 istio-ingressgateway 인입을 위한 접속 정보 확인 kwest get svc -n istio-system istio-ingressgateway NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/istio-ingressgateway LoadBalancer 10.100.0.82 172.18.255.101 15021:30627/TCP,80:30000/TCP,443:31615/TCP,31400:32694/TCP,15443:32016/TCP 119m EXT_IP=$(kwest -n istio-system get svc istio-ingressgateway -o jsonpath='{.status.loadBalancer.ingress[0].ip}') echo $EXT_IP 172.18.255.101 # docker exec -it mypc curl -s -H "Host: webapp.istioinaction.io" http://$EXT_IP/api/catalog | jq [ { "id": 1, "color": "amber", ... # 신규 터미널 : 반복 접속 alias kwest='kubectl --kubeconfig=./west-kubeconfig' EXT_IP=$(kwest -n istio-system get svc istio-ingressgateway -o jsonpath='{.status.loadBalancer.ingress[0].ip}') while true; do docker exec -it mypc curl -s -H "Host: webapp.istioinaction.io" http://$EXT_IP/api/catalog ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; echo; done - kiali : west-cluster 확인

- kiali : east-cluster 확인 , mTLS 통신이며 TCP Traffic 와 HTTP(S) 2개 트래픽 흐름으로 확인됨

- (참고) Istio 의 TCP Traffic 라우팅과 Traffic routing with SNI passthrough 는 4.4.2 를 확인

apiVersion: networking.istio.io/v1alpha3 kind: Gateway metadata: name: sni-passthrough-gateway spec: selector: istio: ingressgateway servers: - port: number: 31400 #1 HTTP 포트가 아닌 특정 포트 열기 name: tcp-sni protocol: TLS hosts: - "simple-sni-1.istioinaction.io" #2 이 호스트를 포트와 연결 tls: mode: PASSTHROUGH #3 통과 트래픽으로 처리 --- apiVersion: networking.istio.io/v1alpha3 kind: VirtualService metadata: name: simple-sni-1-vs spec: hosts: - "simple-sni-1.istioinaction.io" gateways: - sni-passthrough-gateway tls: - match: #1 특정 포트와 호스트의 비교 부분 - port: 31400 sniHosts: - simple-sni-1.istioinaction.io route: - destination: #2 트래픽이 일치하는 경우 라우팅 목적지 host: simple-tls-service-1 port: number: 80 #3 서비스 포트로 라우팅

- (참고) Istio 의 TCP Traffic 라우팅과 Traffic routing with SNI passthrough 는 4.4.2 를 확인

- jaeger : west-cluster 확인

- jaeger : east-cluster 확인

- istio-proxy 로그 확인

# west 에 istio-ingressgateway 로그 kwest logs -n istio-system -l app=istio-ingressgateway -f [2025-05-17T09:59:18.894Z] "GET /api/catalog HTTP/1.1" 200 - via_upstream - "-" 0 357 8 8 "172.18.0.100" "curl/8.7.1" "381b6402-245b-95c4-a090-1bf3362df73b" "webapp.istioinaction.io" "10.10.0.15:8080" outbound|80||webapp.istioinaction.svc.cluster.local 10.10.0.14:57738 10.10.0.14:8080 172.18.0.100:40922 - - # west 에 webapp 로그 kwest logs -n istioinaction -l app=webapp -c istio-proxy -f [2025-05-17T09:56:43.148Z] "GET /api/catalog HTTP/1.1" 200 - via_upstream - "-" 0 357 6 5 "172.18.0.100" "curl/8.7.1" "78234f30-cdbc-9924-82b8-86a0b8c0b74c" "webapp.istioinaction.io" "10.10.0.15:8080" inbound|8080|| 127.0.0.6:52445 10.10.0.15:8080 172.18.0.100:0 outbound_.80_._.webapp.istioinaction.svc.cluster.local default [2025-05-17T09:56:44.279Z] "GET /items HTTP/1.1" 200 - via_upstream - "-" 0 502 4 4 "172.18.0.100" "beegoServer" "2181d9d6-50ba-97b7-b4d8-fb175257b5a8" "catalog.istioinaction.svc.cluster.local:80" "172.18.255.202:15443" outbound|80||catalog.istioinaction.svc.cluster.local 10.10.0.15:36158 10.100.0.170:80 172.18.0.100:0 - default kwest logs -n istioinaction -l app=webapp -c webapp -f 2025/05/17 09:57:39.141 [M] [router.go:1014] 172.18.0.100 - - [17/May/2025 09:57:39] "GET /api/catalog HTTP/1.1 200 0" 0.010450 curl/8.7.1 # west 에 istio-eastwestgateway 로그 kwest exec -it -n istio-system deploy/istio-eastwestgateway -- curl -X POST http://localhost:15000/logging?level=debug kwest logs -n istio-system -l app=istio-eastwestgateway -f ... # east 에 istio-eastwestgateway 로그 keast exec -it -n istio-system deploy/istio-eastwestgateway -- curl -X POST http://localhost:15000/logging?level=debug keast logs -n istio-system -l app=istio-eastwestgateway -f ... # east 에 catalog 로그 keast logs -n istioinaction -l app=catalog -c istio-proxy -f [2025-05-17T10:04:07.297Z] "GET /items HTTP/1.1" 200 - via_upstream - "-" 0 502 1 1 "172.18.0.100" "beegoServer" "4b164067-fbee-9ada-a9b3-84ed7b1cac1e" "catalog.istioinaction.svc.cluster.local:80" "10.20.0.15:3000" inbound|3000|| 127.0.0.6:59201 10.20.0.15:3000 172.18.0.100:0 outbound_.80_._.catalog.istioinaction.svc.cluster.local default keast logs -n istioinaction -l app=catalog -c catalog -f request path: /items blowups: {} number of blowups: 0 GET catalog.istioinaction.svc.cluster.local:80 /items 200 502 - 0.559 ms GET /items 200 0.559 ms - 502 - west : webapp

# kwest exec -it -n istioinaction deploy/webapp -c istio-proxy -- sudo tcpdump -i any tcp -nn kwest exec -it -n istioinaction deploy/webapp -c istio-proxy -- sudo tcpdump -i lo tcp -nn kwest exec -it -n istioinaction deploy/webapp -c istio-proxy -- sudo tcpdump -i eth0 tcp -nn 10:31:42.955656 eth0 Out IP 10.10.0.15.36168 > 172.18.255.202.15443: Flags [P.], seq 2756:4134, ack 3577, win 696, options [nop,nop,TS val 3483540647 ecr 101206706], length 1378 10:31:42.957686 eth0 In IP 172.18.255.202.15443 > 10.10.0.15.36168: Flags [P.], seq 3577:5365, ack 4134, win 826, options [nop,nop,TS val 101207823 ecr 3483540647], length 1788 ... # keast get svc -n istio-system istio-eastwestgateway NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE istio-eastwestgateway LoadBalancer 10.200.0.90 172.18.255.202 15021:32281/TCP,15443:30196/TCP,15012:32628/TCP,15017:32346/TCP 156m - east-catalog